1. 基础篇

讲讲面向对象三大特性

- 封装: 封装最好理解了。封装是面向对象的特征之一,是对象和类概念的主要特性。封装,也就是把客观事物封装成抽象的类,并且类可以把自己的数据和方法只让可信的类或者对象操作,对不可信的进行信息隐藏。

- 继承: 继承是指这样一种能力:它可以使用现有类的所有功能,并在无需重新编写原来的类的情况下对这些功能进行扩展。通过继承创建的新类称为“子类”或“派生类”,被继承的类称为“基类”、“父类”或“超类”。

- 多态性: 它是指在父类中定义的属性和方法被子类继承之后,可以具有不同的数据类型或表现出不同的行为,这使得同一个属性或方法在父类及其各个子类中具有不同的含义。

String,StringBuffer,StringBuilder的区别是什么?

- 可变与不可变

String类中使用字符数组保存字符串,因为有“final”修饰符,所以string对象是不可变的。对于已经存在的String对象的修改都是重新创建一个新的对象,然后把新的值保存进去.

String类利用了final修饰的char类型数组存储字符,源码如下:

private final char value[];

StringBuilder与StringBuffer都继承自AbstractStringBuilder类,在AbstractStringBuilder中也是使用字符数组保存字符串,这两种对象都是可变的。

源码如下:

char[] value;

- 是否多线程安全

String中的对象是不可变的,也就可以理解为常量,显然线程安全。

StringBuilder是非线程安全的。

StringBuffer对方法加了同步锁或者对调用的方法加了同步锁,所以是线程安全的。

源码如下:

@Override

public synchronized StringBuffer append(String str) {

toStringCache = null;

super.append(str);

return this;

}- 性能

每次对String 类型进行改变的时候,都会生成一个新的String对象,然后将指针指向新的String 对象。StringBuffer每次都会对StringBuffer对象本身进行操作,而不是生成新的对象并改变对象引用。相同情况下使用StirngBuilder相比使用StringBuffer仅能获得10%~15% 左右的性能提升,但却要冒多线程不安全的风险。

参考文章:拼接字符串String、StringBuilder、StringBuffer你用对了吗

Java语言有哪些特点?

面向对象(封装,继承,多态);

平台无关性,平台无关性的具体表现在于,Java 是“一次编写,到处运行(Write Once,Run any Where)”的语言,因此采用 Java 语言编写的程序具有很好的可移植性,而保证这一点的正是 Java 的虚拟机机制。在引入虚拟机之后,Java 语言在不同的平台上运行不需要重新编译。

可靠性、安全性;

支持多线程。C++ 语言没有内置的多线程机制,因此必须调用操作系统的多线程功能来进行多线程程序设计,而 Java 语言却提供了多线程支持;

支持网络编程并且很方便。Java 语言诞生本身就是为简化网络编程设计的,因此 Java 语言不仅支持网络编程而且很方便;

编译与解释并存。

什么是字节码?

这个问题,面试官可以扩展提问,Java 是编译执行的语言,还是解释执行的语言?

Java是解释执行语言,Java在Java编译器编译后,形成.class文件,不能直接运行,而是通过JVM解释执行

Java之所以可以“一次编译,到处运行”,一是因为JVM针对各种操作系统、平台都进行了定制,二是因为无论在什么平台,都可以编译生成固定格式的字节码(.class文件)供JVM使用。因此,也可以看出字节码对于Java生态的重要性。

之所以被称之为字节码,是因为字节码文件由十六进制值组成,而JVM以两个十六进制值为一组,即以字节为单位进行读取。在Java中一般是用javac命令编译源代码为字节码文件,一个.java文件从编译到运行的示例如图所示。

采用字节码的好处是什么?

Java语言通过字节码的方式,在一定程度上解决了传统解释型语言执行效率低的问题,同时又保留了解释型语言可移植的特点。所以Java程序运行时比较高效,而且,由于字节码并不专对一种特定的机器,因此,Java程序无须重新编译便可在多种不同的计算机上运行。

Oracle JDK 和 OpenJDK 的区别是什么?

可能在看这个问题之前很多人和我一样并没有接触和使用过 OpenJDK 。下面通过我通过我收集到一些资料对你解答这个被很多人忽视的问题。

- Oracle JDK 版本将每三年发布一次,而 OpenJDK 版本每三个月发布一次;

- OpenJDK 是一个参考模型并且是完全开源的,而 Oracle JDK 是OpenJDK 的一个实现,并不是完全开源的;

- Oracle JDK 比 OpenJDK 更稳定。OpenJDK 和 Oracle JDK 的代码几乎相同,但 Oracle JDK 有更多的类和一些错误修复。因此,如果您想开发企业/商业软件,建议选择 Oracle JDK,因为它经过了彻底的测试和稳定。某些情况下,有些人提到在使用 OpenJDK 可能会遇到了许多应用程序崩溃的问题,但是,只需切换到 Oracle JDK 就可以解决问题;

- 在响应性和 JVM 性能方面,Oracle JDK 与 OpenJDK 相比提供了更好的性能;

- Oracle JDK 不会为即将发布的版本提供长期支持,用户每次都必须通过更新到最新版本获得支持来获取最新版本;

- Oracle JDK 根据二进制代码许可协议获得许可,而 OpenJDK 根据 GPLv2 许可获得许可。

访问修饰符public、private、protected、以及不写(默认)时的区别?

Java中,可以使用访问控制符来保护对类、变量、方法和构造方法的访问。Java 支持 4 种不同的访问权限。

- default (即默认,什么也不写): 在同一包内可见,不使用任何修饰符。使用对象:类、接口、变量、方法。

- private : 在同一类内可见。使用对象:变量、方法。 注意:不能修饰类(外部类)

- public : 对所有类可见。使用对象:类、接口、变量、方法

- protected : 对同一包内的类和所有子类可见。使用对象:变量、方法。 注意:不能修饰类(外部类)。

ArrayList和LinkedList区别

数组是基于索引的数据结构,使用索引在数组中搜索和读取数据是很快的。数组获取数据的时间复杂度是O(1),但是在进行删除的时候开销很大,因为需要对数组进行重排(删除位置后的元素需要整体向前移动)。

数组在初始化的时候必须指定长度,并在堆内存中分配空间。

ArrayList是底层是通过“可变长”数组来实现的,因此具有了数组的特性。ArrayList的变长本质是数组的重新创建和扩容,根据扩容因子来确定是否需要扩容,单次扩容的长度是当前数组长度的0.5倍。具体ArrayList的详细信息见博客。

ArrayList源码(一):java1.8源码之ArrayList源码解读

ArrayList源码(二):扩容和移位、删除元素详解

LinkedList是基于双向链表实现的,链表节点在堆中无需连续,通过节点的首尾指针建立节点间的关联关系。

在进行新增、删除的时候,LinkedList相对于ArrayList效率会更高一点,但在查询方面ArrayList要比LinkedList效率高。在插入元素的时候,ArrayList效率要比LinkedList效率低一点,因为ArrayList涉及元素的复制移位,甚至重新开辟内存的问题。不过这些比较都是在数据量较大的、操作复杂的情况下成立的,反之,各自的优缺点就没有这么明显了,可以忽略。

HashMap和Hashtable的区别

- 两者父类不同:HashMap是继承自AbstractMap类,而Hashtable是继承自Dictionary类;

- 对null的支持不同:Hashtable的Key和Value都不能为null,HashMap的可以为null,但是只能出现一次,因为需要保证Key值的唯一性。Value值不需要保证唯一性,多个不同的Key下的Value都是可以为null的。

- 安全性不同:Hashtable是线程安全的,HashMap是非线程安全的,在Hashtable内,每个方法都添加了synchronized关键字。

- 效率方面不同:安全性和效率是相斥的,Hashtable的每个方法都添加了synchronized关键字,增加了锁的开销,就会导致执行效率的降低,反之HashMap的效率要优于Hashtable的,在没有多线程共用、竞争的情况下,最优的选择就是HashMap。

HashMap和ConcurrentHashMap的区别

ConcurrentHashMap和HashMap都是采用同样的数据存储结构,实现过程基本相同。但是由于HashMap是非线程安全的,使用Hashtable效率又很低。因此引入了ConcurrentHashMap,在提供线程安全的前提下,最大化提高效率。ConcurrentHashMap采用了分段锁机制,在数据结构的插槽级别增加锁机制,在保证并发(最大并发量是插槽的总数量)的情况下,实现对不同插槽进行锁的实现,保证数据安全。

对比异同点

- 都是 key-value 形式的存储数据;

- HashMap 是线程不安全的,ConcurrentHashMap 是 J.U.C 下的线程安全的;

- HashMap 底层数据结构是数组 + 链表(JDK 1.8 之前)。JDK 1.8 之后是数组 + 链表 + 红黑树。当链表中元素个数达到 8 的时候,链表的查询速度不如红黑树快,链表会转为红黑树,红黑树查询速度快;

- HashMap 初始数组大小为 16(默认),当出现扩容的时候,以 0.75 * 数组大小的方式进行扩容;

- ConcurrentHashMap 在 JDK 1.8 之前是采用分段锁来现实的 Segment + HashEntry,Segment 数组大小默认是 16,2 的 n 次方;JDK 1.8 之后,采用 Node + CAS + Synchronized来保证并发安全进行实现。

JDK7、8对ConcurrentHashMap的实现和总结

try catch finally,try里面有return,finally还执行吗?

finally会执行的,且finally的执行早于try里面return的执行。

结论

- 不管有没有出现异常,finally块中代码都会执行;

- 当try和catch中有return时,finally任然会执行;

- finally是在return后面的表达式运算后执行的(此时并没有返回运算后的值,而是先把要返回的值保存起来,不管finally中的代码怎么样,返回的值都不会改变,仍然是之前保存的值),所以函数返回值是在finally执行前确定的;

- finally中最好不要包括return,否则程序会提前退出,返回值不是try或者catch中保存的返回值。

Java序列化中如果有些字段不想进行序列化,怎么办?

对于不想进行序列化的变量,使用transient关键字修饰。

transient关键字的作用:

阻止实例中那些用此关键字修饰的变量序列化;当对象被反序列时,被transient修饰的变量值不会被持久化和恢复。transient只能修饰变量,不能修饰类和方法。

java 创建对象有哪几种方式?

java中提供了以下四种创建对象的方式:

- 使用new关键字;

- 使用反射方式创建对象,newInstance()方法;

- 使用clone方法,包括浅克隆和深克隆;

- 使用反序列化创建对象,使用ObjectInputStream类的readObject()方法。

前两者都需要显式地调用构造方法。对于clone机制,需要注意浅拷贝和深拷贝的区别,对于序列化机制需要明确其实现原理,在java中序列化可以通过实现Externalizable或者Serializable来实现。

ArrayList有什么特点

- Java集合框架中的一种存放相同类型的元素数据集合,是一种变长的集合类,基于定长数组实现,当加入数据达到一定程度,会实现自动扩容,即扩大数组大小;

- 当使用add(O),添加到数组的尾部,可能触发扩容机制;

- 当使用add(int,O),添加到数组的指定位置,可能会需要挪动大量的数组元素,并且可能触发扩容机制;

- 当可预见数组容量,可以在创建ArrayList对象的时候初始化其容量,降低后续扩容带来的性能消耗;

- 高并发的情况下,线程不安全,会引发不可预见的异常或错误;

- ArrayList实现了Cloneable接口,表示它可以被复制(浅复制)。

说说什么是fail-fast

fail-fast机制是Java集合(Collection)中的一种错误机制,当多个线程对同一个集合的内容进行操作时,就可能触发fail-fast事件。

当一个线程A通Iterator去遍历某个集合的过程中,若改集合的内容被其他线程所改变了,那么线程A访问集合时,就会抛出ConcurrentModificationException异常,产生fail-fast事件。(这里的操作主要是指add、remove和clear,会引起数组元素数量变化的操作)

主要机制:在Iterator内中维护了一个expectModCount属性,在Java集合中维护了一个modCount字段,创建Iterator迭代器的时候,会将最新的modCount值赋值给expectModCount。当在使用Iterator遍历集合的时候,每次取集合内元素,都会对比expectModCount和modCount是否相同,如果不相同,说明集合被迭代器以外的线程操作修改了,于是就抛出ConcurrentModificationException异常。

HashMap的长度为什么是2的N次方呢?

为能让HashMap存数据和取数据的效率高,尽可能地减少hash值的碰撞,也就是说尽量把数据能均匀的分配,每个链表或者红黑树长度尽量相同。

在这样的情况下,首先想到的是取模(%)操作来实现。在取余(%)的时候,如果除数是2的幂次,则等价于与其除数减一的与(&)操作。并且采用二进制位操作&,相对于%能够提高运行效率。

hash % length == hash & (length -1)因此HashMap的长度需要2的N次方。

红黑树有哪几个特征?

在ConcurrentHashMap问完后,你肯定会回答ConcurrentHashMap的数据结构,在JDK1.8以后,采用的是数组、链表+红黑树的结构存储,在链表长度达到8以上后,红黑树的查询效率会比链表好。紧接着面试官就会为红黑树的特征。

- 每个节点都是黑色或者红色;

- 根节点是黑色;

- 每个叶子节点都是黑色(指向空的叶子节点);

- 如果一个叶子节点是红色,那么其子节点必须都是黑色;

- 从一个节点到该节点的子孙节点的所有路径上包含相同数据的黑节点。

说说平时是怎么处理Java异常的

正常处理标准流程:try-catch-finally

- try块负责监控可能出现异常的代码

- catch块负责捕获可能出现的异常,并进行处理

- finally块负责清理各种资源,不管是否出现异常都会执行

- 其中try块是必须的,catch和finally至少存在一个标准异常处理流程

优化点

- try块要合理的界定区间,不将大量无关的代码也圈入,影响整体的性能;

- catch捕获异常后,可以采用三种解决方案,第一通过对异常的处理,封装成自定义异常抛出;第二可以通过日志记录异常信息后,将原始异常直接抛出;第三是将无需处理的异常进行记录,不中断流程,继续业务代码的执行。其中第一、二种解决方案可以配合切面或者Spring Boot自带的异常处理机制,从控制层统一做异常的处理。

- finally中是在异常发生后,对需要释放的资源等做最后的保证,需要注意finally内不能使用return,这样会导致程序提前退出,try、catch块中做的处理后的返回值无法返回。

说说什么是单例模式

单例模式是一种常用的软件设计模式,在应用这个模式时,单例对象的类必须保证只有一个实例存在,整个系统只能使用一个对象实例。

优点:不会频繁地创建和销毁对象,浪费系统资源。

可能这会需要你手写一个单例模式,这就得自己去学了,因为单例模式有很多种写法,懒汉模式,饿汉模式,双重检查模式等。懒汉模式就是用的时候再去创建对象,饿汉模式就是提前就已经加载好的静态static对象,双重检查模式就是两次检查避免多线程造成创建了多个对象。

单例模式有很多种的写法,我总结一下:

- 饿汉式单例模式:线程安全

- 懒汉式单例模式:非线程安全

- 双检锁单例模式:线程安全

- 静态内部类模式:线程安全

- 枚举模式:线程安全

说说你对代理模式的理解

代理模式是给某一个对象提供一个代理,并由代理对象控制对原对象的引用。

优点:

- 代理模式能够协调调用者和被调用者,在一定程度上降低了系统的耦合度;

- 可以灵活地隐藏被代理对象的部分功能和服务,也增加额外的功能和服务。

缺点:

- 由于使用了代理模式,因此程序的性能没有直接调用性能高;

- 使用代理模式提高了代码的复杂度。

黄牛卖火车票:没有流行网络购票的年代是很喜欢找黄牛买火车票的,因为工作忙的原因,没时间去买票,然后就托黄牛给你买张回家过年的火车票。这个过程中黄牛就是代理人,火车票就是被代理的对象。

婚姻介绍所:婚姻介绍所的工作人员,搜集单身人士信息,婚介所的工作人员为这个单身人士找对象,这个过程也是代理模式的生活案例。对象就是被代理的对象。

注意了,问代理模式的时候,很有可能会问:动态代理。在Spring篇中已经讲述过,如果你把动态代理讲了后,很有可能还会问什么是静态代理?

说说工厂模式

简单工厂模式又叫静态工厂方法模式,就是建立一个工厂类,对实现了同一接口的一些类进行实例的创建。比如,一台咖啡机就可以理解为一个工厂模式,你只需要按下想喝的咖啡品类的按钮(摩卡或拿铁),它就会给你生产一杯相应的咖啡,你不需要管它内部的具体实现,只要告诉它你的需求即可。

优点:

- 工厂类含有必要的判断逻辑,可以决定在什么时候创建哪一个产品类的实例,客户端可以免除直接创建产品对象的责任,而仅仅“消费”产品;简单工厂模式通过这种做法实现了对责任的分割,它提供了专门的工厂类用于创建对象;

- 客户端无须知道所创建的具体产品类的类名,只需要知道具体产品类所对应的参数即可,对于一些复杂的类名,通过简单工厂模式可以减少使用者的记忆量;

- 通过引入配置文件,可以在不修改任何客户端代码的情况下更换和增加新的具体产品类,在一定程度上提高了系统的灵活性。

缺点:

- 不易拓展,一旦添加新的产品类型,就不得不修改工厂的创建逻辑;

- 产品类型较多时,工厂的创建逻辑可能过于复杂,一旦出错可能造成所有产品的创建失败,不利于系统的维护。

抽象工厂模式

抽象工厂模式是在简单工厂的基础上将未来可能需要修改的代码抽象出来,通过继承的方式让子类去做决定。

比如,以上面的咖啡工厂为例,某天我的口味突然变了,不想喝咖啡了想喝啤酒,这个时候如果直接修改简单工厂里面的代码,这种做法不但不够优雅,也不符合软件设计的“开闭原则”,因为每次新增品类都要修改原来的代码。这个时候就可以使用抽象工厂类了,抽象工厂里只声明方法,具体的实现交给子类(子工厂)去实现,这个时候再有新增品类的需求,只需要新创建代码即可。

装饰器模式是什么

装饰器模式是指动态地给一个对象增加一些额外的功能,同时又不改变其结构。

优点:装饰类和被装饰类可以独立发展,不会相互耦合,装饰模式是继承的一个替代模式,装饰模式可以动态扩展一个实现类的功能。

装饰器模式的关键:装饰器中使用了被装饰的对象。

模板方法模式

模板方法模式是指定义一个算法骨架,将具体内容延迟到子类去实现。

优点:

- 提高代码复用性:将相同部分的代码放在抽象的父类中,而将不同的代码放入不同的子类中;

- 实现了反向控制:通过一个父类调用其子类的操作,通过对子类的具体实现扩展不同的行为,实现了反向控制并且符合开闭原则。

享元模式

顾名思义就是被共享的单元。享元模式的意图是复用对象,节省内存,前提是享元对象是不可变对象。

具体来讲,当一个系统中存在大量重复对象的时候,如果这些重复的对象是不可变对象,我们就可以利用享元模式将对象设计成享元,在内存中只保留一份实例,供多处代码引用。这样可以减少内存中对象的数量,起到节省内存的目的。

典型的使用场景:Integer中cache,就是享元模式很经典的实现。

享元模式和单例模式的区别

单例模式是创建型模式,重在只能有一个对象。而享元模式是结构型模式,重在节约内存使用,提升程序性能。

享元模式:把一个或者多个对象缓存起来,用的时候,直接从缓存里获取。也就是说享元模式不一定只有一个对象。

说说策略模式在我们生活的场景

策略模式是指定义一系列算法,将每个算法都封装起来,并且使他们之间可以相互替换。

优点: 遵循了开闭原则,扩展性良好。

缺点: 随着策略的增加,对外暴露越来越多。

条条大路通罗马,条条大路通北京。

我们去北京的交通方式(策略)很多,比如说坐飞机、坐高铁、自己开车等方式。每一种方式就可以理解为每一种策略。

这就是生活中的策略模式。

适配器模式

适配器模式是将一个类的接口变成客户端所期望的另一种接口,从而使原本因接口不匹配而无法一起工作的两个类能够在一起工作。

优点:

- 可以让两个没有关联的类一起运行,起着中间转换的作用;

- 灵活性好,不会破坏原有的系统。

缺点:

过多地使用适配器,容易使代码结构混乱,如明明看到调用的是 A 接口,内部调用的却是 B接口的实现。

生活中的插座,为了适应各种插头,然后上面有两个孔的,三个空的,基本都能适应。还有万能充电器、USB接口等。这些都是生活中的适配器模式。

观察者模式

观察者模式是定义对象间的一种一对多依赖关系,使得每当一个对象状态发生改变时,其相关依赖对象皆得到通知并被自动更新。观察者模式又叫做发布-订阅(Publish/Subscribe)模式、模型-视图(Model/View)模式、源-监听器(Source/Listener)模式或从属者(Dependents)模式。

优点:

- 观察者模式可以实现表示层和数据逻辑层的分离,并定义了稳定的消息更新传递机制,抽象了更新接口,使得可以有各种各样不同的表示层作为具体观察者角色;

- 观察者模式在观察目标和观察者之间建立一个抽象的耦合;

- 观察者模式支持广播通信;

- 观察者模式符合开闭原则(对拓展开放,对修改关闭)的要求。

缺点:

- 如果一个观察目标对象有很多直接和间接的观察者的话,将所有的观察者都通知到会花费很多时间;

- 如果在观察者和观察目标之间有循环依赖的话,观察目标会触发它们之间进行循环调用,可能导致系统崩溃;

- 观察者模式没有相应的机制让观察者知道所观察的目标对象是怎么发生变化的,而仅仅只是知道观察目标发生了变化。

在观察者模式中有如下角色:

- Subject:抽象主题(抽象被观察者),抽象主题角色把所有观察者对象保存在一个集合里,每个主题都可以有任意数量的观察者,抽象主题提供一个接口,可以增加和删除观察者对象;

- ConcreteSubject:具体主题(具体被观察者),该角色将有关状态存入具体观察者对象,在具体主题的内部状态- 发生改变时,给所有注册过的观察者发送通知;

- Observer:抽象观察者,是观察者者的抽象类,它定义了一个更新接口,使得在得到主题更改通知时更新自己;

- ConcrereObserver:具体观察者,实现抽象观察者定义的更新接口,以便在得到主题更改通知时更新自身的状态。

在Spring中大量的使用的观察者模式,只要看到是以Event结尾或者Publish开头的基本上都是观察者模式。

什么是不可变对象?好处是什么?

不可变对象指对象一旦被创建,状态就不能再改变,任何修改都会创建一个新的对象,如 String、Integer及其它包装类。不可变对象最大的好处是线程安全。

值传递和引用传递的区别的什么?为什么说Java中只有值传递?

值传递:指的是在方法调用时,传递的参数是按值的拷贝传递,传递的是值的拷贝,也就是说传递后就互不相关了。

引用传递:指的是在方法调用时,传递的参数是按引用进行传递,其实传递的是引用的地址,也就是变量所对应的内存空间的地址。传递的是值的引用,也就是说传递前和传递后都指向同一个引用(也就是同一个内存空间)。

基本类型作为参数被传递时肯定是值传递;引用类型作为参数被传递时也是值传递,只不过“值”为对应的引用。

想要深入了解,可以参考这篇文章 :http://www.itwanger.com/java/2019/11/26/java-yinyong-value.html

介绍下hashCode()

hashCode()的作用是获取哈希码,也称为散列码;它实际上是返回一个int整数。这个哈希码的作用是确定该对象在哈希表中的索引位置。hashCode()定义在JDK的Object.java中,这就意味着Java中的任何类都包含有hashCode()函数。

散列表存储的是键值对(key-value),它的特点是:能根据“键”快速的检索出对应的“值”。这其中就利用到了散列码!(可以快速找到所需要的对象)

为什么重写equals方法必须重写hashcode方法

判断的时候先根据hashcode进行的判断,相同的情况下再根据equals()方法进行判断。如果只重写了equals方法,而不重写hashcode的方法,会造成hashcode的值不同,而equals()方法判断出来的结果为true。

在Java中的一些容器中,不允许有两个完全相同的对象,插入的时候,如果判断相同则会进行覆盖。这时候如果只重写了equals()的方法,而不重写hashcode的方法,Object中hashcode是根据对象的存储地址转换而形成的一个哈希值。这时候就有可能因为没有重写hashcode方法,造成相同的对象散列到不同的位置而造成对象的不能覆盖的问题。

String为什么要设计成不可变的

- 便于实现字符串池(String pool)

在Java中,由于会大量的使用String常量,如果每一次声明一个String都创建一个String对象,那将会造成极大的空间资源的浪费。Java提出了String pool的概念,在堆中开辟一块存储空间String pool,当初始化一个String变量时,如果该字符串已经存在了,就不会去创建一个新的字符串变量,而是会返回已经存在了的字符串的引用。

String a = "Hello world!";

String b = "Hello world!";如果字符串是可变的,某一个字符串变量改变了其值,那么其指向的变量的值也会改变,String pool将不能够实现!

- 使多线程安全

在并发场景下,多个线程同时读一个资源,是安全的,不会引发竞争,但对资源进行写操作时是不安全的,不可变对象不能被写,所以保证了多线程的安全。

- 避免安全问题

在网络连接和数据库连接中字符串常常作为参数,例如,网络连接地址URL,文件路径path,反射机制所需要的String参数。其不可变性可以保证连接的安全性。如果字符串是可变的,黑客就有可能改变字符串指向对象的值,那么会引起很严重的安全问题。

- 加快字符串处理速度

由于String是不可变的,保证了hashcode的唯一性,于是在创建对象时其hashcode就可以放心的缓存了,不需要重新计算。这也就是Map喜欢将String作为Key的原因,处理速度要快过其它的键对象。所以HashMap中的键往往都使用String。

总体来说,String不可变的原因要包括 设计考虑,效率优化,以及安全性这三大方面。

深拷贝和浅拷贝的区别

浅拷贝: 被复制对象的所有变量都含有与原来的对象相同的值,而所有的对其他对象的引用仍然指向原来的对象,换言之,浅拷贝仅仅复制所考虑的对象,而不复制它所有引用的对象。(源对象内引用的对象不复制,复制后的对象和源对象共用)

深拷贝: 被复制对象的所有变量都含有与原来的对象相同的值,而那些引用其他对象的变量将指向被复制过的新对象。不再是原来被引用的对象。换言之,深拷贝把要复制的对象及所引用的对象都复制了一遍。

break ,continue ,return 的区别及作用?

break 跳出总上一层循环,不再执行循环(结束当前的循环体)

continue 跳出本次循环,继续执行下次循环(结束正在执行的循环 进入下一个循环条件)

return 程序返回,不再执行下面的代码(结束当前的方法,直接返回)

final、finally、finalize的区别?

final 用于修饰变量、方法和类。

- final 变量:被修饰的变量不可变,不可变分为

引用不可变和对象不可变,final 指的是引用不可变,final 修饰的变量必须初始化,通常称被修饰的变量为常量。 - final 方法:被修饰的方法不允许任何子类重写,子类可以使用该方法。

- final 类:被修饰的类不能被继承,所有方法不能被重写。

finally 作为异常处理的一部分,它只能在 try/catch 语句中,并且附带一个语句块表示这段语句最终一定被执行(无论是否抛出异常),经常被用在需要释放资源的情况下,System.exit (0) 可以阻断 finally 执行。

finalize 是在 java.lang.Object 里定义的方法,也就是说每一个对象都有这么个方法,这个方法在 gc 启动,该对象被回收的时候被调用。

一个对象的 finalize 方法只会被调用一次,finalize 被调用不一定会立即回收该对象,所以有可能调用 finalize 后,该对象又不需要被回收了,然后到了真正要被回收的时候,因为前面调用过一次,所以不会再次调用 finalize 了,进而产生问题,因此不推荐使用 finalize 方法。

为什么要用static关键字?

通常来说,用new创建类的对象时,数据存储空间才被分配,方法才供外界调用。但有时我们只想为特定域分配单一存储空间,不考虑要创建多少对象或者说根本就不创建任何对象,再就是我们想在没有创建对象的情况下也想调用方法。在这两种情况下,static关键字,满足了我们的需求。

”static”关键字是什么意思?Java中是否可以覆盖(override)一个private或者是static的方法?

“static”关键字表明一个成员变量或者是成员方法可以在没有所属的类的实例变量的情况下被访问。

Java中static方法不能被覆盖,因为方法覆盖是基于运行时动态绑定的,而static方法是编译时静态绑定的。static方法跟类的任何实例都不相关,所以概念上不适用。

是否可以在static环境中访问非static变量?

static变量在Java中是属于类的,它在所有的实例中的值是一样的。当类被Java虚拟机载入的时候,会对static变量进行初始化。如果你的代码尝试不用实例来访问非static的变量,编译器会报错,因为这些变量还没有被创建出来,还没有跟任何实例关联上。

static静态方法能不能引用非静态资源?

不能,new的时候才会产生的东西,对于初始化后就存在的静态资源来说,根本不认识它。

static静态方法里面能不能引用静态资源?

可以,因为都是类初始化的时候加载的,大家相互都认识。

非静态方法里面能不能引用静态资源?

可以,非静态方法就是实例方法,那是new之后才产生的,那么属于类的内容它都认识。

java静态变量、代码块、和静态方法的执行顺序是什么?

基本上代码块分为三种:Static静态代码块、构造代码块、普通代码块

代码块执行顺序静态代码块——> 构造代码块 ——> 构造函数——> 普通代码块

继承中代码块执行顺序:父类静态块——>子类静态块——>父类代码块——>父类构造器——>子类代码块——>子类构造器

Java语言是如何实现多态的?

本质上多态分两种:

1、编译时多态(又称静态多态)

2、运行时多态(又称动态多态)

重载(overload)就是编译时多态的一个例子,编译时多态在编译时就已经确定,运行的时候调用的是确定的方法。

我们通常所说的多态指的都是运行时多态,也就是编译时不确定究竟调用哪个具体方法,一直延迟到运行时才能确定。这也是为什么有时候多态方法又被称为延迟方法的原因。

Java实现多态有 3 个必要条件:继承、重写和向上转型。只有满足这 3 个条件,开发人员才能够在同一个继承结构中使用统一的逻辑实现代码处理不同的对象,从而执行不同的行为。

- 继承:在多态中必须存在有继承关系的子类和父类。

- 重写:子类对父类中某些方法进行重新定义,在调用这些方法时就会调用子类的方法。

- 向上转型:在多态中需要将子类的引用赋给父类对象,只有这样该引用才既能可以调用父类的方法,又能调用子类的方法。

重载(Overload)和重写(Override)的区别是什么?

方法的重载和重写都是实现多态的方式,区别在于前者实现的是编译时的多态性,而后者实现的是运行时的多态性。

- 重写发生在子类与父类之间, 重写方法返回值和形参都不能改变,与方法返回值和访问修饰符无关,即重写的方法不能根据返回类型进行区分。即外壳不变,核心重写!

- 重载(overloading) 是在一个类里面,方法名字相同,而参数不同。返回类型可以相同也可以不同。每个重载的方法(或者构造函数)都必须有一个独一无二的参数类型列表。最常用的地方就是构造器的重载。

抽象类和接口的区别是什么?

语法层面上的区别:

- 抽象类可以提供成员方法的实现细节,而接口中只能存在public abstract 方法;

- 抽象类中的成员变量可以是各种类型的,而接口中的成员变量只能是public static final类型的;

- 接口中不能含有静态代码块以及静态方法,而抽象类可以有静态代码块和静态方法;

- 一个类只能继承一个抽象类,而一个类却可以实现多个接口。

设计层面上的区别:

- 抽象类是对一种事物的抽象,即对类抽象,而接口是对行为的抽象。抽象类是对整个类整体进行抽象,包括属性、行为,但是接口却是对类局部(行为)进行抽象。

- 设计层面不同,抽象类作为很多子类的父类,它是一种模板式设计。而接口是一种行为规范,它是一种辐射式设计。

== 和 equals 区别是什么?

==常用于相同的基本数据类型之间的比较,也可用于相同类型的对象之间的比较;

- 如果

==比较的是基本数据类型,那么比较的是两个基本数据类型的值是否相等; - 如果

==是比较的两个对象,那么比较的是两个对象的引用,也就是判断两个对象是否指向了同一块内存区域;

equals方法主要用于两个对象之间,检测一个对象是否等于另一个对象

看一看Object类中equals方法的源码:

public boolean equals(Object obj) {

return (this == obj);

}它的作用也是判断两个对象是否相等,一般有两种使用情况:

- 情况1,类没有覆盖equals()方法。则通过equals()比较该类的两个对象时,等价于通过“==”比较这两个对象。

- 情况2,类覆盖了equals()方法。一般,我们都覆盖equals()方法来两个对象的内容相等;若它们的内容相等,则返回true(即,认为这两个对象相等)。

java语言规范要求equals方法具有以下特性:

- 自反性。对于任意不为null的引用值x,x.equals(x)一定是true。

- 对称性。对于任意不为null的引用值x和y,当且仅当x.equals(y)是true时,y.equals(x)也是true。

- 传递性。对于任意不为null的引用值x、y和z,如果x.equals(y)是true,同时y.equals(z)是true,那么x.equals(z)一定是true。

- 一致性。对于任意不为null的引用值x和y,如果用于equals比较的对象信息没有被修改的话,多次调用时x.equals(y)要么一致地返回true要么一致地返回false。

- 对于任意不为null的引用值x,x.equals(null)返回false。

为什么要有 hashCode?

以“HashSet 如何检查重复”为例子来说明为什么要有 hashCode:

当你把对象加入 HashSet 时,HashSet 会先计算对象的 hashcode 值来判断对象加入的位置,同时也会与其他已经加入的对象的 hashcode 值作比较,如果没有相符的hashcode,HashSet会假设对象没有重复出现。

但是如果发现有相同 hashcode 值的对象,这时会调用 equals()方法来检查 hashcode 相等的对象是否真的相同。如果两者相同,HashSet 就不会让其加入操作成功。如果不同的话,就会重新散列到其他位置。这样我们就大大减少了 equals 的次数,相应就大大提高了执行速度。

hashCode(),equals()两种方法是什么关系?

要弄清楚这两种方法的关系,就需要对哈希表有一个基本的认识。其基本的结构如下:

对于hashcode方法,会返回一个哈希值,哈希值对数组的长度取余后会确定一个存储的下标位置,如图中用数组括起来的第一列。

不同的哈希值取余之后的结果可能是相同的,用equals方法判断是否为相同的对象,不同则在链表中插入。

则有hashCode()与equals()的相关规定:

- 如果两个对象相等,则hashcode一定也是相同的;

- 两个对象相等,对两个对象分别调用equals方法都返回true;

- 两个对象有相同的hashcode值,它们也不一定是相等的。

字符型常量和字符串常量的区别

形式上: 字符常量是单引号引起的一个字符,字符串常量是双引号引起的若干个字符;

含义上: 字符常量相当于一个整型值( ASCII 值),可以参加表达式运算;字符串常量代表一个地址值(该字符串在内存中存放位置,相当于对象);

占内存大小:字符常量只占2个字节;字符串常量占若干个字节(至少一个字符结束标志) (注意: char 在Java中占两个字节)。

什么是字符串常量池?

java中常量池的概念主要有三个:全局字符串常量池,class文件常量池,运行时常量池。我们现在所说的就是全局字符串常量池,对这个想弄明白的同学可以看这篇Java中几种常量池的区分。

JVM为了提升性能和减少内存开销,避免字符的重复创建,其维护了一块特殊的内存空间,即字符串池,当需要使用字符串时,先去字符串池中查看该字符串是否已经存在,如果存在,则可以直接使用,如果不存在,初始化,并将该字符串放入字符串常量池中。

字符串常量池的位置也是随着JDK版本的不同而不同。在JDK6中,常量池的位置在永久代(方法区)中,此时常量池中存储的是对象。在JDK7中,常量池的位置在堆中,此时,常量池存储的就是引用了。在JDK8中,永久代(方法区)被元空间取代了。

String有哪些特性?

不变性:String 是只读字符串,是一个典型的 immutable 对象,对它进行任何操作,其实都是创建一个新的对象,再把引用指向该对象。不变模式的主要作用在于当一个对象需要被多线程共享并频繁访问时,可以保证数据的一致性;

常量池优化:String 对象创建之后,会在字符串常量池中进行缓存,如果下次创建同样的对象时,会直接返回缓存的引用;

final:使用 final 来定义 String 类,表示 String 类不能被继承,提高了系统的安全性。

在使用 HashMap 的时候,用 String 做 key 有什么好处?

HashMap 内部实现是通过 key 的 hashcode 来确定 value 的存储位置,因为字符串是不可变的,所以当创建字符串时,它的 hashcode 被缓存下来,不需要再次计算,所以相比于其他对象更快。

包装类型是什么?基本类型和包装类型有什么区别?

Java 为每一个基本数据类型都引入了对应的包装类型(wrapper class),int 的包装类就是 Integer,从 Java 5 开始引入了自动装箱/拆箱机制,把基本类型转换成包装类型的过程叫做装箱(boxing);反之,把包装类型转换成基本类型的过程叫做拆箱(unboxing),使得二者可以相互转换。

Java 为每个原始类型提供了包装类型:

原始类型: boolean,char,byte,short,int,long,float,double

包装类型:Boolean,Character,Byte,Short,Integer,Long,Float,Double

基本类型和包装类型的区别主要有以下 几点:

包装类型可以为 null,而基本类型不可以。它使得包装类型可以应用于 POJO 中,而基本类型则不行。那为什么 POJO 的属性必须要用包装类型呢?《阿里巴巴 Java 开发手册》上有详细的说明, 数据库的查询结果可能是 null,如果使用基本类型的话,因为要自动拆箱(将包装类型转为基本类型,比如说把 Integer 对象转换成 int 值),就会抛出

NullPointerException的异常。包装类型可用于泛型,而基本类型不可以。泛型不能使用基本类型,因为使用基本类型时会编译出错。

List<int> list = new ArrayList<>(); // 提示 Syntax error, insert "Dimensions" to complete ReferenceType List<Integer> list = new ArrayList<>();

因为泛型在编译时会进行类型擦除,最后只保留原始类型,而原始类型只能是 Object 类及其子类——基本类型是个特例。

- 基本类型比包装类型更高效。基本类型在栈中直接存储的具体数值,而包装类型则存储的是堆中的引用。 很显然,相比较于基本类型而言,包装类型需要占用更多的内存空间和更长的访问路径。

解释一下自动装箱和自动拆箱?

自动装箱:将基本数据类型重新转化为对象

public class Test {

public static void main(String[] args) {

// 声明一个Integer对象,用到了自动的装箱:解析为:Integer num = Integer.valueOf(9);

Integer num = 9;

}

} 9是属于基本数据类型的,原则上它是不能直接赋值给一个对象Integer的。但JDK1.5开始引入了自动装箱/拆箱机制,就可以进行这样的声明,自动将基本数据类型转化为对应的封装类型,成为一个对象以后就可以调用对象所声明的所有的方法。

自动拆箱:将对象重新转化为基本数据类型

public class Test {

public static void main(String[] args) {

/ /声明一个Integer对象

Integer num = 9;

// 进行计算时隐含的有自动拆箱

System.out.print(num--);

}

} 因为对象是不能直接进行运算的,而是要转化为基本数据类型后才能进行加减乘除。

int 和 Integer 有什么区别?

- Integer是int的包装类;int是基本数据类型;

- Integer变量必须实例化后才能使用;int变量不需要;

- Integer实际是对象的引用,指向此new的Integer对象;int是直接存储数据值 ;

- Integer的默认值是null;int的默认值是0。

两个new生成的Integer变量的对比

由于Integer变量实际上是对一个Integer对象的引用,所以两个通过new生成的Integer变量永远是不相等的(因为new生成的是两个对象,其内存地址不同)。

Integer i = new Integer(10000);

Integer j = new Integer(10000);

System.out.print(i == j); //falseInteger变量和int变量的对比

Integer变量和int变量比较时,只要两个变量的值是相等的,则结果为true(因为包装类Integer和基本数据类型int比较时,java会自动拆包装为int,然后进行比较,实际上就变为两个int变量的比较)

int a = 10000;

Integer b = new Integer(10000);

Integer c=10000;

System.out.println(a == b); // true

System.out.println(a == c); // true非new生成的Integer变量和new Integer()生成变量的对比

非new生成的Integer变量和new Integer()生成的变量比较时,结果为false。(因为非new生成的Integer变量指向的是java常量池中的对象,而new Integer()生成的变量指向堆中新建的对象,两者在内存中的地址不同)

Integer b = new Integer(10000);

Integer c=10000;

System.out.println(b == c); // false两个非new生成的Integer对象的对比

对于两个非new生成的Integer对象,进行比较时,如果两个变量的值在区间-128到127之间,则比较结果为true,如果两个变量的值不在此区间,则比较结果为false

Integer i = 100;

Integer j = 100;

System.out.print(i == j); //true

Integer i = 128;

Integer j = 128;

System.out.print(i == j); //false当值在 -128 ~ 127之间时,java会进行自动装箱,然后会对值进行缓存,如果下次再有相同的值,会直接在缓存中取出使用。缓存是通过Integer的内部类IntegerCache来完成的。当值超出此范围,会在堆中new出一个对象来存储。

给一个Integer对象赋一个int值的时候,会调用Integer类的静态方法valueOf,源码如下:

public static Integer valueOf(String s, int radix) throws NumberFormatException {

return Integer.valueOf(parseInt(s,radix));

}/**

* (1)在-128~127之内:静态常量池中cache数组是static final类型,cache数组对象会被存储于静态常量池中。

* cache数组里面的元素却不是static final类型,而是cache[k] = new Integer(j++),

* 那么这些元素是存储于堆中,只是cache数组对象存储的是指向了堆中的Integer对象(引用地址)

*

* (2)在-128~127 之外:新建一个 Integer对象,并返回。

*/

public static Integer valueOf(int i) {

assert IntegerCache.high >= 127;

if (i >= IntegerCache.low && i <= IntegerCache.high) {

return IntegerCache.cache[i + (-IntegerCache.low)];

}

return new Integer(i);

}

IntegerCache是Integer的内部类,源码如下:

/**

* 缓存支持自动装箱的对象标识语义 -128和127(含)。

* 缓存在第一次使用时初始化。 缓存的大小可以由-XX:AutoBoxCacheMax = <size>选项控制。

* 在VM初始化期间,java.lang.Integer.IntegerCache.high属性可以设置并保存在私有系统属性中

*/

private static class IntegerCache {

static final int low = -128;

static final int high;

static final Integer cache[];

static {

// high value may be configured by property

int h = 127;

String integerCacheHighPropValue =

sun.misc.VM.getSavedProperty("java.lang.Integer.IntegerCache.high");

if (integerCacheHighPropValue != null) {

int i = parseInt(integerCacheHighPropValue);

i = Math.max(i, 127);

// Maximum array size is Integer.MAX_VALUE

h = Math.min(i, Integer.MAX_VALUE - (-low) -1);

}

high = h;

cache = new Integer[(high - low) + 1];

int j = low;

for(int k = 0; k < cache.length; k++) {

cache[k] = new Integer(j++); // 创建一个对象

}

}

private IntegerCache() {}

}

什么是反射?

反射是在运行状态中,对于任意一个类,都能够知道这个类的所有属性和方法;对于任意一个对象,都能够调用它的任意一个方法和属性;这种动态获取的信息以及动态调用对象的方法的功能称为 Java 语言的反射机制。

如何获取反射中的Class对象?

Class.forName(“类的路径”);当你知道该类的全路径名时,你可以使用该方法获取 Class 类对象。

Class clz = Class.forName("java.lang.String");类名.class。这种方法只适合在编译前就知道操作的 Class。

Class clz = String.class;对象名.getClass()。

String str = new String("Hello"); Class clz = str.getClass();如果是基本类型的包装类,可以调用包装类的Type属性来获得该包装类的Class对象。

Java反射的作用与原理

定义

反射机制是在运行时,对于任意一个类,都能够知道这个类的所有属性和方法;对于任意个对象,都能够调用它的任意一个方法。在Java中,只要给定类的名字,就可以通过反射机制来获得类的所有信息。

反射的实现方式

- Class.forName(“类的路径”);

- 类名.class

- 对象名.getClass

- 基于类型的包装类,可以调用包装类的Type属性来获得该包装类的Class对象

实现Java反射的类

- Class:表示正在运行的Java应用程序中的类和接口(所有获取对象的信息都需要Class类来实现);

- Field:提供有关类和接口的属性信息,以及对它的动态访问权限;

- Constructor:提供关于类的单个构造方法的信息以及访问权限;

- Method:提供类或接口中某个方法的信息。

反射机制的优缺点

优点

- 能够运行时动态获取类的示例,提高灵活性;

- 与动态编译结合(如加载MySQL数据库驱动)。

缺点

- 使用反射性能较低,需要解析字节码,将内存中的对象进行解析;

- 相对不安全,破坏了封装性(通过反射可以获取私有的方法和属性)。

针对反射性能低的解决方案

- 通过setAccessible关闭JDK的安全检查来提升反射速度;

- 多次创建一个类的实例时,有缓存会快很多;

- ReflectASM工具类,通过字节码生成的方式加快反射速度。

反射使用的步骤?

获取想要操作的类的Class对象,这是反射的核心,通过Class对象我们可以任意调用类的方法。

调用 Class 类中的方法,既就是反射的使用阶段。

使用反射 API 来操作这些信息。

具体可以看下面的例子:

public class Apple {

private int price;

public int getPrice() {

return price;

}

public void setPrice(int price) {

this.price = price;

}

public static void main(String[] args) throws Exception{

//正常的调用

Apple apple = new Apple();

apple.setPrice(5);

System.out.println("Apple Price:" + apple.getPrice());

//使用反射调用

Class clz = Class.forName("com.chenshuyi.api.Apple");

Method setPriceMethod = clz.getMethod("setPrice", int.class);

Constructor appleConstructor = clz.getConstructor();

Object appleObj = appleConstructor.newInstance();

setPriceMethod.invoke(appleObj, 14);

Method getPriceMethod = clz.getMethod("getPrice");

System.out.println("Apple Price:" + getPriceMethod.invoke(appleObj));

}

}从代码中可以看到我们使用反射调用了 setPrice 方法,并传递了 14 的值。之后使用反射调用了 getPrice 方法,输出其价格。上面的代码整个的输出结果是:

Apple Price:5

Apple Price:14从这个简单的例子可以看出,一般情况下我们使用反射获取一个对象的步骤:

- 获取类的 Class 对象实例

Class clz = Class.forName("com.zhenai.api.Apple");- 根据 Class 对象实例获取 Constructor 对象

Constructor appleConstructor = clz.getConstructor();- 使用 Constructor 对象的 newInstance 方法获取反射类对象

Object appleObj = appleConstructor.newInstance();而如果要调用某一个方法,则需要经过下面的步骤:

- 获取方法的 Method 对象

Method setPriceMethod = clz.getMethod("setPrice", int.class);- 利用 invoke 方法调用方法

setPriceMethod.invoke(appleObj, 14);为什么引入反射概念?反射机制的应用有哪些?

我们来看一下 Oracle 官方文档中对反射的描述:

从 Oracle 官方文档中可以看出,反射主要应用在以下几方面:

- 反射让开发人员可以通过外部类的全路径名创建对象,并使用这些类,实现一些扩展的功能。

- 反射让开发人员可以枚举出类的全部成员,包括构造函数、属性、方法。以帮助开发者写出正确的代码。

- 测试时可以利用反射 API 访问类的私有成员,以保证测试代码覆盖率。

也就是说,Oracle 希望开发者将反射作为一个工具,用来帮助程序员实现本不可能实现的功能。

举两个最常见使用反射的例子,来说明反射机制的强大之处:

第一种:JDBC 的数据库的连接

在JDBC 的操作中,如果要想进行数据库的连接,则必须按照以上的几步完成

- 通过Class.forName()加载数据库的驱动程序 (通过反射加载,前提是引入相关了Jar包);

- 通过 DriverManager 类进行数据库的连接,连接的时候要输入数据库的连接地址、用户名、密码;

- 通过Connection 接口接收连接。

public class ConnectionJDBC {

/**

* @param args

*/

//驱动程序就是之前在classpath中配置的JDBC的驱动程序的JAR 包中

public static final String DBDRIVER = "com.mysql.jdbc.Driver";

//连接地址是由各个数据库生产商单独提供的,所以需要单独记住

public static final String DBURL = "jdbc:mysql://localhost:3306/test";

//连接数据库的用户名

public static final String DBUSER = "root";

//连接数据库的密码

public static final String DBPASS = "";

public static void main(String[] args) throws Exception {

Connection con = null; //表示数据库的连接对象

Class.forName(DBDRIVER); //1、使用CLASS 类加载驱动程序 ,反射机制的体现

con = DriverManager.getConnection(DBURL,DBUSER,DBPASS); //2、连接数据库

System.out.println(con);

con.close(); // 3、关闭数据库

}

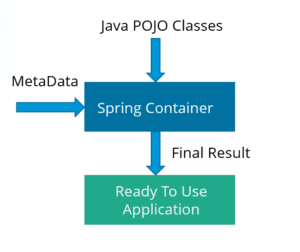

第二种:Spring 框架的使用,最经典的就是xml的配置模式。

Spring 通过 XML 配置模式装载 Bean 的过程:

- 将程序内所有 XML 或 Properties 配置文件加载入内存中;

- Java类里面解析xml或properties里面的内容,得到对应实体类的字节码字符串以及相关的属性信息;

- 使用反射机制,根据这个字符串获得某个类的Class实例;

- 动态配置实例的属性。

Spring这样做的好处是:

- 不用每一次都要在代码里面去new或者做其他的事情;

- 以后要改的话直接改配置文件,代码维护起来就很方便了;

- 有时为了适应某些需求,Java类里面不一定能直接调用另外的方法,可以通过反射机制来实现。

模拟 Spring 加载 XML 配置文件:

public class BeanFactory {

private Map<String, Object> beanMap = new HashMap<String, Object>();

/**

* bean工厂的初始化.

* @param xml xml配置文件

*/

public void init(String xml) {

try {

//读取指定的配置文件

SAXReader reader = new SAXReader();

ClassLoader classLoader = Thread.currentThread().getContextClassLoader();

//从class目录下获取指定的xml文件

InputStream ins = classLoader.getResourceAsStream(xml);

Document doc = reader.read(ins);

Element root = doc.getRootElement();

Element foo;

//遍历bean

for (Iterator i = root.elementIterator("bean"); i.hasNext();) {

foo = (Element) i.next();

//获取bean的属性id和class

Attribute id = foo.attribute("id");

Attribute cls = foo.attribute("class");

//利用Java反射机制,通过class的名称获取Class对象

Class bean = Class.forName(cls.getText());

//获取对应class的信息

java.beans.BeanInfo info = java.beans.Introspector.getBeanInfo(bean);

//获取其属性描述

java.beans.PropertyDescriptor pd[] = info.getPropertyDescriptors();

//设置值的方法

Method mSet = null;

//创建一个对象

Object obj = bean.newInstance();

//遍历该bean的property属性

for (Iterator ite = foo.elementIterator("property"); ite.hasNext();) {

Element foo2 = (Element) ite.next();

//获取该property的name属性

Attribute name = foo2.attribute("name");

String value = null;

//获取该property的子元素value的值

for(Iterator ite1 = foo2.elementIterator("value"); ite1.hasNext();) {

Element node = (Element) ite1.next();

value = node.getText();

break;

}

for (int k = 0; k < pd.length; k++) {

if (pd[k].getName().equalsIgnoreCase(name.getText())) {

mSet = pd[k].getWriteMethod();

//利用Java的反射极致调用对象的某个set方法,并将值设置进去

mSet.invoke(obj, value);

}

}

}

//将对象放入beanMap中,其中key为id值,value为对象

beanMap.put(id.getText(), obj);

}

} catch (Exception e) {

System.out.println(e.toString());

}

}

//other codes

}反射机制的原理是什么?

Class actionClass=Class.forName(“MyClass”);

Object action=actionClass.newInstance();

Method method = actionClass.getMethod(“myMethod”,null);

method.invoke(action,null);上面就是最常见的反射使用的例子,前两行实现了类的装载、链接和初始化(newInstance方法实际上也是使用反射调用了

因反射原理较复杂,下面简要描述下流程,想要详细了解的小伙伴,可以看这篇文章:https://www.cnblogs.com/yougewe/p/10125073.html

- 反射获取类实例 Class.forName(),并没有将实现留给了java,而是交给了jvm去加载!主要是先获取 ClassLoader, 然后调用 native 方法,获取信息,加载类则是回调 java.lang.ClassLoader。最后,jvm又会回调 ClassLoader 进类加载!

- newInstance() 主要做了三件事:

- 权限检测,如果不通过直接抛出异常;

- 查找无参构造器,并将其缓存起来;

- 调用具体方法的无参构造方法,生成实例并返回。

- 获取Method对象,

上面的Class对象是在加载类时由JVM构造的,JVM为每个类管理一个独一无二的Class对象,这份Class对象里维护着该类的所有Method,Field,Constructor的cache,这份cache也可以被称作根对象。

每次getMethod获取到的Method对象都持有对根对象的引用,因为一些重量级的Method的成员变量(主要是MethodAccessor),我们不希望每次创建Method对象都要重新初始化,于是所有代表同一个方法的Method对象都共享着根对象的MethodAccessor,每一次创建都会调用根对象的copy方法复制一份:

Method copy() {

Method res = new Method(clazz, name, parameterTypes, returnType,

exceptionTypes, modifiers, slot, signature,

annotations, parameterAnnotations, annotationDefault);

res.root = this;

res.methodAccessor = methodAccessor;

return res;

}- 调用invoke()方法。调用invoke方法的流程如下:

调用Method.invoke之后,会直接去调MethodAccessor.invoke。MethodAccessor就是上面提到的所有同名method共享的一个实例,由ReflectionFactory创建。

创建机制采用了一种名为inflation的方式(JDK1.4之后):如果该方法的累计调用次数<=15,会创建出NativeMethodAccessorImpl,它的实现就是直接调用native方法实现反射;如果该方法的累计调用次数>15,会由java代码创建出字节码组装而成的MethodAccessorImpl。(是否采用inflation和15这个数字都可以在jvm参数中调整)

以调用MyClass.myMethod(String s)为例,生成出的MethodAccessorImpl字节码翻译成Java代码大致如下:

public class GeneratedMethodAccessor1 extends MethodAccessorImpl {

public Object invoke(Object obj, Object[] args) throws Exception {

try {

MyClass target = (MyClass) obj;

String arg0 = (String) args[0];

target.myMethod(arg0);

} catch (Throwable t) {

throw new InvocationTargetException(t);

}

}

}Java中的泛型是什么 ?

泛型是 JDK1.5 的一个新特性,泛型就是将类型参数化,其在编译时才确定具体的参数。这种参数类型可以用在类、接口和方法的创建中,分别称为泛型类、泛型接口、泛型方法。

使用泛型的好处是什么?

远在 JDK 1.4 版本的时候,那时候是没有泛型的概念的,如果使用 Object 来实现通用、不同类型的处理,有这么两个缺点:

- 每次使用时都需要强制转换成想要的类型

- 在编译时编译器并不知道类型转换是否正常,运行时才知道,不安全。

如这个例子:

List list = new ArrayList();

list.add("www.cnblogs.com");

list.add(23);

String name = (String)list.get(0);

String number = (String)list.get(1); //ClassCastException上面的代码在运行时会发生强制类型转换异常。这是因为我们在存入的时候,第二个是一个 Integer 类型,但是取出来的时候却将其强制转换为 String 类型了。Sun 公司为了使 Java 语言更加安全,减少运行时异常的发生。于是在 JDK 1.5 之后推出了泛型的概念。

根据《Java 编程思想》中的描述,泛型出现的动机在于:有许多原因促成了泛型的出现,而最引人注意的一个原因,就是为了创建容器类。

使用泛型的好处有以下几点:

类型安全

- 泛型的主要目标是提高 Java 程序的类型安全

- 编译时期就可以检查出因 Java 类型不正确导致的 ClassCastException 异常

- 符合越早出错代价越小原则

消除强制类型转换

- 泛型的一个附带好处是,使用时直接得到目标类型,消除许多强制类型转换

- 所得即所需,这使得代码更加可读,并且减少了出错机会

潜在的性能收益

- 由于泛型的实现方式,支持泛型(几乎)不需要 JVM 或类文件更改

- 所有工作都在编译器中完成

- 编译器生成的代码跟不使用泛型(和强制类型转换)时所写的代码几乎一致,只是更能确保类型安全而已

Java泛型的原理是什么 ? 什么是类型擦除 ?

泛型是一种语法糖,泛型这种语法糖的基本原理是类型擦除。Java中的泛型基本上都是在编译器这个层次来实现的,也就是说:泛型只存在于编译阶段,而不存在于运行阶段。在编译后的 class 文件中,是没有泛型这个概念的。

类型擦除:使用泛型的时候加上的类型参数,编译器在编译的时候去掉类型参数。

例如:

public class Caculate<T> {

private T num;

}我们定义了一个泛型类,定义了一个属性成员,该成员的类型是一个泛型类型,这个 T 具体是什么类型,我们也不知道,它只是用于限定类型的。反编译一下这个 Caculate 类:

public class Caculate{

public Caculate(){}

private Object num;

}发现编译器擦除 Caculate 类后面的两个尖括号,并且将 num 的类型定义为 Object 类型。

那么是不是所有的泛型类型都以 Object 进行擦除呢?大部分情况下,泛型类型都会以 Object 进行替换,而有一种情况则不是。那就是使用到了extends和super语法的有界类型,如:

public class Caculate<T extends String> {

private T num;

}这种情况的泛型类型,num 会被替换为 String 而不再是 Object。这是一个类型限定的语法,它限定 T 是 String 或者 String 的子类,也就是你构建 Caculate 实例的时候只能限定 T 为 String 或者 String 的子类,所以无论你限定 T 为什么类型,String 都是父类,不会出现类型不匹配的问题,于是可以使用 String 进行类型擦除。

实际上编译器会正常的将使用泛型的地方编译并进行类型擦除,然后返回实例。但是除此之外的是,如果构建泛型实例时使用了泛型语法,那么编译器将标记该实例并关注该实例后续所有方法的调用,每次调用前都进行安全检查,非指定类型的方法都不能调用成功。

实际上编译器不仅关注一个泛型方法的调用,它还会为某些返回值为限定的泛型类型的方法进行强制类型转换,由于类型擦除,返回值为泛型类型的方法都会擦除成 Object 类型,当这些方法被调用后,编译器会额外插入一行 checkcast 指令用于强制类型转换。这一个过程就叫做『泛型翻译』。

什么是泛型中的限定通配符和非限定通配符 ?

限定通配符对类型进行了限制。有两种限定通配符,一种是<? extends T>它通过确保类型必须是T的子类来设定类型的上界,另一种是<? super T>它通过确保类型必须是T的父类来设定类型的下界。泛型类型必须用限定内的类型来进行初始化,否则会导致编译错误。

非限定通配符 ?,可以用任意类型来替代。如List<?> 的意思是这个集合是一个可以持有任意类型的集合,它可以是List<A>,也可以是List<B>,或者List<C>等等。

List<? extends T>和List <? super T>之间有什么区别 ?

这两个List的声明都是限定通配符的例子,List<? extends T>可以接受任何继承自T的类型的List,而List<? super T>可以接受任何T的父类构成的List。例如List<? extends Number>可以接受List

可以把List<String>传递给一个接受List<Object>参数的方法吗?

不可以。真这样做的话会导致编译错误。因为List<Object>可以存储任何类型的对象包括String, Integer等等,而List<String>却只能用来存储String。

List<Object> objectList;

List<String> stringList;

objectList = stringList; //compilation error incompatible typesArray中可以用泛型吗?

不可以。这也是为什么 Joshua Bloch 在 《Effective Java》一书中建议使用 List 来代替 Array,因为 List 可以提供编译期的类型安全保证,而 Array 却不能。

判断ArrayList<String>与ArrayList<Integer>是否相等?

ArrayList<String> a = new ArrayList<String>();

ArrayList<Integer> b = new ArrayList<Integer>();

Class c1 = a.getClass();

Class c2 = b.getClass();

System.out.println(c1 == c2); 输出的结果是 true。因为无论对于ArrayList<String>还是ArrayList<Integer>,它们的Class类型都是一致的,都是ArrayList.class。

那它们声明时指定的 String 和 Integer 到底体现在哪里呢?

答案是体现在类编译的时候。当 JVM 进行类编译时,会进行泛型检查,如果一个集合被声明为 String 类型,那么它往该集合存取数据的时候就会对数据进行判断,从而避免存入或取出错误的数据。

Java序列化与反序列化是什么?

Java序列化是指把Java对象转换为字节序列的过程,而Java反序列化是指把字节序列恢复为Java对象的过程:

序列化:序列化是把对象转换成有序字节流,以便在网络上传输或者保存在本地文件中。核心作用是对象状态的保存与重建。我们都知道,Java对象是保存在JVM的堆内存中的,也就是说,如果JVM堆不存在了,那么对象也就跟着消失了。

而序列化提供了一种方案,可以让你在即使JVM停机的情况下也能把对象保存下来的方案。就像我们平时用的U盘一样。把Java对象序列化成可存储或传输的形式(如二进制流),比如保存在文件中。这样,当再次需要这个对象的时候,从文件中读取出二进制流,再从二进制流中反序列化出对象。

反序列化:客户端从文件中或网络上获得序列化后的对象字节流,根据字节流中所保存的对象状态及描述信息,通过反序列化重建对象。

为什么需要序列化与反序列化

简要描述:对内存中的对象进行持久化或网络传输, 这个时候都需要序列化和反序列化

深入描述:

- 对象序列化可以实现分布式对象

主要应用例如:RMI(即远程调用Remote Method Invocation)要利用对象序列化运行远程主机上的服务,就像在本地机上运行对象时一样。

- java对象序列化不仅保留一个对象的数据,而且递归保存对象引用的每个对象的数据

可以将整个对象层次写入字节流中,可以保存在文件中或在网络连接上传递。利用对象序列化可以进行对象的”深复制”,即复制对象本身及引用的对象本身。序列化一个对象可能得到整个对象序列。

- 序列化可以将内存中的类写入文件或数据库中

比如:将某个类序列化后存为文件,下次读取时只需将文件中的数据反序列化就可以将原先的类还原到内存中。也可以将类序列化为流数据进行传输。

总的来说就是将一个已经实例化的类转成文件存储,下次需要实例化的时候只要反序列化即可将类实例化到内存中并保留序列化时类中的所有变量和状态。

- 对象、文件、数据,有许多不同的格式,很难统一传输和保存

序列化以后就都是字节流了,无论原来是什么东西,都能变成一样的东西,就可以进行通用的格式传输或保存,传输结束以后,要再次使用,就进行反序列化还原,这样对象还是对象,文件还是文件。

序列化实现的方式有哪些

实现Serializable接口或者Externalizable接口。

Serializable接口

类通过实现 java.io.Serializable 接口以启用其序列化功能。可序列化类的所有子类型本身都是可序列化的。序列化接口没有方法或字段,仅用于标识可序列化的语义。

Externalizable接口

Externalizable继承自Serializable,该接口中定义了两个抽象方法:writeExternal()与readExternal()。

当使用Externalizable接口来进行序列化与反序列化的时候需要开发人员重写writeExternal()与readExternal()方法。否则所有变量的值都会变成默认值。

两种序列化的对比

| 实现Serializable接口 | 实现Externalizable接口 |

|---|---|

| 系统自动存储必要的信息 | 程序员决定存储哪些信息 |

| Java内建支持,易于实现,只需要实现该接口即可,无需任何代码支持 | 必须实现接口内的两个方法 |

| 性能略差 | 性能略好 |

serialVersionUID

serialVersionUID 用来表明类的不同版本间的兼容性

Java的序列化机制是通过在运行时判断类的serialVersionUID来验证版本一致性的。在进行反序列化时,JVM会把传来的字节流中的serialVersionUID与本地相应实体(类)的serialVersionUID进行比较,如果相同就认为是一致的,可以进行反序列化,否则就会出现序列化版本不一致的异常。

为什么还要显示指定serialVersionUID的值

如果不显示指定serialVersionUID, JVM在序列化时会根据属性自动生成一个serialVersionUID, 然后与属性一起序列化, 再进行持久化或网络传输. 在反序列化时, JVM会再根据属性自动生成一个新版serialVersionUID, 然后将这个新版serialVersionUID与序列化时生成的旧版serialVersionUID进行比较, 如果相同则反序列化成功, 否则报错。

如果显示指定了, JVM在序列化和反序列化时仍然都会生成一个serialVersionUID, 但值为我们显示指定的值, 这样在反序列化时新旧版本的serialVersionUID就一致了。

在实际开发中, 不显示指定serialVersionUID的情况会导致什么问题? 如果我们的类写完后不再修改, 那当然不会有问题, 但这在实际开发中是不可能的, 我们的类会不断迭代, 一旦类被修改了, 那旧对象反序列化就会报错. 所以在实际开发中, 我们都会显示指定一个serialVersionUID, 值是多少无所谓, 只要不变就行。

Java 序列化中如果有些字段不想进行序列化,怎么办?

对于不想进行序列化的变量,使用 transient 关键字修饰。

transient 关键字的作用是控制变量的序列化,在变量声明前加上该关键字,可以阻止该变量被序列化到文件中,在被反序列化后,transient 变量的值被设为初始值,如 int 型的是 0,对象型的是 null。transient 只能修饰变量,不能修饰类和方法。

静态变量会被序列化吗

不会。因为序列化是针对对象而言的, 而静态变量优先于对象存在, 随着类的加载而加载, 所以不会被序列化。

看到这个结论, 是不是有人会问, serialVersionUID也被static修饰, 为什么serialVersionUID会被序列化? 其实serialVersionUID属性并没有被序列化, JVM在序列化对象时会自动生成一个serialVersionUID, 然后将我们显示指定的serialVersionUID属性值赋给自动生成的serialVersionUID。

Error 和 Exception 区别是什么?

Java 中,所有的异常都有一个共同的祖先 java.lang 包中的 Throwable 类。Throwable 类有两个重要的子类 Exception(异常)和 Error(错误)。

Exception 和 Error 二者都是 Java 异常处理的重要子类,各自都包含大量子类。

Exception:程序本身可以处理的异常,可以通过catch来进行捕获,通常遇到这种错误,应对其进行处理,使应用程序可以继续正常运行。Exception又可以分为运行时异常(RuntimeException, 又叫非受检查异常)和非运行时异常(又叫受检查异常) 。Error:Error属于程序无法处理的错误 ,我们没办法通过catch来进行捕获 。例如,系统崩溃,内存不足,堆栈溢出等,编译器不会对这类错误进行检测,一旦这类错误发生,通常应用程序会被终止,仅靠应用程序本身无法恢复。

非受检查异常(运行时异常)和受检查异常(一般异常)区别是什么?

非受检查异常:包括 RuntimeException 类及其子类,表示 JVM 在运行期间可能出现的异常。 Java 编译器不会检查运行时异常。例如:NullPointException(空指针)、NumberFormatException(字符串转换为数字)、IndexOutOfBoundsException(数组越界)、ClassCastException(类转换异常)、ArrayStoreException(数据存储异常,操作数组时类型不一致)等。

受检查异常:是Exception 中除 RuntimeException 及其子类之外的异常。 Java 编译器会检查受检查异常。常见的受检查异常有: IO 相关的异常、ClassNotFoundException 、SQLException等。

非受检查异常和受检查异常之间的区别:是否强制要求调用者必须处理此异常,如果强制要求调用者必须进行处理,那么就使用受检查异常,否则就选择非受检查异常。

try-catch-finally 中哪个部分可以省略?

catch 可以省略。更为严格的说法其实是:try只适合处理运行时异常,try+catch适合处理运行时异常+普通异常。也就是说,如果你只用try去处理普通异常却不加以catch处理,编译是通不过的,因为编译器硬性规定,普通异常如果选择捕获,则必须用catch显示声明以便进一步处理。而运行时异常在编译时没有如此规定,所以catch可以省略,你加上catch编译器也觉得无可厚非。

理论上,编译器看任何代码都不顺眼,都觉得可能有潜在的问题,所以你即使对所有代码加上try,代码在运行期时也只不过是在正常运行的基础上加一层皮。但是你一旦对一段代码加上try,就等于显示地承诺编译器,对这段代码可能抛出的异常进行捕获而非向上抛出处理。如果是普通异常,编译器要求必须用catch捕获以便进一步处理;如果运行时异常,捕获然后丢弃并且+finally扫尾处理,或者加上catch捕获以便进一步处理。

至于加上finally,则是在不管有没捕获异常,都要进行的“扫尾”处理。

try-catch-finally 中,如果 catch 中 return 了,finally 还会执行吗?

会执行,在 return 前执行。

在 finally 中改变返回值的做法是不好的,因为如果存在 finally 代码块,try中的 return 语句不会立马返回调用者,而是记录下返回值待 finally 代码块执行完毕之后再向调用者返回其值,然后如果在 finally 中修改了返回值,就会返回修改后的值。显然,在 finally 中返回或者修改返回值会对程序造成很大的困扰,Java 中也可以通过提升编译器的语法检查级别来产生警告或错误。

代码示例1:

public static int getInt() {

int a = 10;

try {

System.out.println(a / 0);

a = 20;

} catch (ArithmeticException e) {

a = 30;

return a;

/*

* return a 在程序执行到这一步的时候,这里不是return a 而是 return 30;这个返回路径就形成了

* 但是呢,它发现后面还有finally,所以继续执行finally的内容,a=40

* 再次回到以前的路径,继续走return 30,形成返回路径之后,这里的a就不是a变量了,而是常量30

*/

} finally {

a = 40;

}

return a;

}

//执行结果:30代码示例2:

public static int getInt() {

int a = 10;

try {

System.out.println(a / 0);

a = 20;

} catch (ArithmeticException e) {

a = 30;

return a;

} finally {

a = 40;

//如果这样,就又重新形成了一条返回路径,由于只能通过1个return返回,所以这里直接返回40

return a;

}

}

// 执行结果:40Java常见异常有哪些

- java.lang.IllegalAccessError:违法访问错误。当一个应用试图访问、修改某个类的域(Field)或者调用其方法,但是又违反域或方法的可见性声明,则抛出该异常。

- java.lang.InstantiationError:实例化错误。当一个应用试图通过Java的new操作符构造一个抽象类或者接口时抛出该异常。

- java.lang.OutOfMemoryError:内存不足错误。当可用内存不足以让Java虚拟机分配给一个对象时抛出该错误。

- java.lang.StackOverflowError:堆栈溢出错误。当一个应用递归调用的层次太深而导致堆栈溢出或者陷入死循环时抛出该错误。

- java.lang.ClassCastException:类造型异常。假设有类A和B(A不是B的父类或子类),O是A的实例,那么当强制将O构造为类B的实例时抛出该异常。该异常经常被称为强制类型转换异常。

- java.lang.ClassNotFoundException:找不到类异常。当应用试图根据字符串形式的类名构造类,而在遍历CLASSPAH之后找不到对应名称的class文件时,抛出该异常。

- java.lang.ArithmeticException:算术条件异常。譬如:整数除零等。

- java.lang.ArrayIndexOutOfBoundsException:数组索引越界异常。当对数组的索引值为负数或大于等于数组大小时抛出。

- java.lang.IndexOutOfBoundsException:索引越界异常。当访问某个序列的索引值小于0或大于等于序列大小时,抛出该异常。

- java.lang.InstantiationException:实例化异常。当试图通过newInstance()方法创建某个类的实例,而该类是一个抽象类或接口时,抛出该异常。

- java.lang.NoSuchFieldException:属性不存在异常。当访问某个类的不存在的属性时抛出该异常。

- java.lang.NoSuchMethodException:方法不存在异常。当访问某个类的不存在的方法时抛出该异常。

- java.lang.NullPointerException:空指针异常。当应用试图在要求使用对象的地方使用了null时,抛出该异常。譬如:调用null对象的实例方法、访问null对象的属性、计算null对象的长度、使用throw语句抛出null等等。

- java.lang.NumberFormatException:数字格式异常。当试图将一个String转换为指定的数字类型,而该字符串确不满足数字类型要求的格式时,抛出该异常。

- java.lang.StringIndexOutOfBoundsException:字符串索引越界异常。当使用索引值访问某个字符串中的字符,而该索引值小于0或大于等于序列大小时,抛出该异常。

JVM 是如何处理异常的?

在一个方法中如果发生异常,这个方法会创建一个异常对象,并转交给 JVM,该异常对象包含异常名称,异常描述以及异常发生时应用程序的状态。创建异常对象并转交给 JVM 的过程称为抛出异常。可能有一系列的方法调用,最终才进入抛出异常的方法,这一系列方法调用的有序列表叫做调用栈。

JVM 会顺着调用栈去查找看是否有可以处理异常的代码,如果有,则调用异常处理代码。当 JVM 发现可以处理异常的代码时,会把发生的异常传递给它。如果 JVM 没有找到可以处理该异常的代码块,JVM 就会将该异常转交给默认的异常处理器(默认处理器为 JVM 的一部分),默认异常处理器打印出异常信息并终止应用程序。

想要深入了解的小伙伴可以看这篇文章:https://www.cnblogs.com/qdhxhz/p/10765839.html

Java的IO流分为几种?

- 按照流的方向:输入流(inputStream)和输出流(outputStream);

- 按照实现功能分:节点流(可以从或向一个特定的地方读写数据,如 FileReader)和处理流(是对一个已存在的流的连接和封装,通过所封装的流的功能调用实现数据读写, BufferedReader);

- 按照处理数据的单位: 字节流和字符流。分别由四个抽象类来表示(每种流包括输入和输出两种所以一共四个):InputStream,OutputStream,Reader,Writer。Java中其他多种多样变化的流均是由它们派生出来的。

字节流如何转为字符流?

字节输入流转字符输入流通过 InputStreamReader 实现,该类的构造函数可以传入 InputStream 对象。

字节输出流转字符输出流通过 OutputStreamWriter 实现,该类的构造函数可以传入 OutputStream 对象。

字符流与字节流的区别?

- 读写的时候字节流是按字节读写,字符流按字符读写。

- 字节流适合所有类型文件的数据传输,因为计算机字节(Byte)是电脑中表示信息含义的最小单位。字符流只能够处理纯文本数据,其他类型数据不行,但是字符流处理文本要比字节流处理文本要方便。

- 在读写文件需要对内容按行处理,比如比较特定字符,处理某一行数据的时候一般会选择字符流。

- 只是读写文件,和文件内容无关时,一般选择字节流。

BIO、NIO、AIO的区别

- BIO:同步并阻塞,在服务器中实现的模式为一个连接一个线程。也就是说,客户端有连接请求的时候,服务器就需要启动一个线程进行处理,如果这个连接不做任何事情会造成不必要的线程开销,当然这也可以通过线程池机制改善。BIO一般适用于连接数目小且固定的架构,这种方式对于服务器资源要求比较高,而且并发局限于应用中,是JDK1.4之前的唯一选择,但好在程序直观简单,易理解。

- NIO:同步并非阻塞,在服务器中实现的模式为一个请求一个线程,也就是说,客户端发送的连接请求都会注册到多路复用器上,多路复用器轮询到有连接IO请求时才会启动一个线程进行处理。NIO一般适用于连接数目多且连接比较短(轻操作)的架构,并发局限于应用中,编程比较复杂,从JDK1.4开始支持。

- AIO:异步并非阻塞,在服务器中实现的模式为一个有效请求一个线程,也就是说,客户端的IO请求都是通过操作系统先完成之后,再通知服务器应用去启动线程进行处理。AIO一般适用于连接数目多且连接比较长(重操作)的架构,充分调用操作系统参与并发操作,编程比较复杂,从JDK1.7开始支持。

Java IO都有哪些设计模式?

使用了适配器模式和装饰器模式

适配器模式:

Reader reader = new InputStreamReader(inputStream);把一个类的接口变换成客户端所期待的另一种接口,从而使原本因接口不匹配而无法在一起工作的两个类能够在一起工作

- 类适配器:Adapter类(适配器)继承Adaptee类(源角色)实现Target接口(目标角色)

- 对象适配器:Adapter类(适配器)持有Adaptee类(源角色)对象实例,实现Target接口(目标角色)

装饰器模式:

new BufferedInputStream(new FileInputStream(inputStream));一种动态地往一个类中添加新的行为的设计模式。就功能而言,装饰器模式相比生成子类更为灵活,这样可以给某个对象而不是整个类添加一些功能。

- ConcreteComponent(具体对象)和Decorator(抽象装饰器)实现相同的Conponent(接口)并且Decorator(抽象装饰器)里面持有Conponent(接口)对象,可以传递请求。

- ConcreteComponent(具体装饰器)覆盖Decorator(抽象装饰器)的方法并用super进行调用,传递请求。

常见的集合有哪些

Java集合类主要由两个根接口Collection和Map派生出来的,Collection派生出了三个子接口:List、Set、Queue(Java5新增的队列),因此Java集合大致也可分成List、Set、Queue、Map四种接口体系。

注意:Collection是一个接口,Collections是一个工具类,Map不是Collection的子接口。

Java集合框架图如下:

图中,List代表了有序可重复集合,可直接根据元素的索引来访问;Set代表无序不可重复集合,只能根据元素本身来访问;Queue是队列集合。

Map代表的是存储key-value对的集合,可根据元素的key来访问value。

上图中淡绿色背景覆盖的是集合体系中常用的实现类,分别是ArrayList、LinkedList、ArrayQueue、HashSet、TreeSet、HashMap、TreeMap等实现类。

线程安全的集合有哪些?线程不安全的呢?

线程安全的:

- Hashtable:比HashMap多了个线程安全。

- ConcurrentHashMap:是一种高效且线程安全的集合。

- Vector:比Arraylist多了个同步化机制。

- Stack:栈,也是线程安全的,继承于Vector。

线性不安全的:

- HashMap

- Arraylist

- LinkedList

- HashSet

- TreeSet

- TreeMap

Arraylist与LinkedList异同点

- 是否保证线程安全: ArrayList 和 LinkedList 都是不同步的,也就是不保证线程安全;

- 底层数据结构: Arraylist 底层使用的是Object数组;LinkedList 底层使用的是双向循环链表数据结构;

- 插入和删除是否受元素位置的影响: ArrayList 采用数组存储,所以插入和删除元素的时间复杂度受元素位置的影响。 比如:执行add(E e)方法的时候, ArrayList 会默认在将指定的元素追加到此列表的末尾,这种情况时间复杂度就是O(1)。但是如果要在指定位置 i 插入和删除元素的话(add(int index, E element))时间复杂度就为 O(n-i)。因为在进行上述操作的时候集合中第 i 和第 i 个元素之后的(n-i)个元素都要执行向后位/向前移一位的操作。 LinkedList 采用链表存储,所以插入,删除元素时间复杂度不受元素位置的影响,都是近似 O(1)而数组为近似 O(n)。

- 是否支持快速随机访问: LinkedList 不支持高效的随机元素访问,而ArrayList 实现了RandmoAccess 接口,所以有随机访问功能。快速随机访问就是通过元素的序号快速获取元素对象(对应于get(int index)方法)。

- 内存空间占用: ArrayList的空间浪费主要体现在list列表的结尾会预留一定的容量空间,而LinkedList的空间花费则体现在它的每一个元素都需要消耗比ArrayList更多的空间(因为要存放直接后继和直接前驱以及本身数据)。

Array和ArrayList有什么区别

- Array可以包含基本类型和对象类型,ArrayList只能包含对象类型。

- Array大小是固定的(不支持扩容),ArrayList的大小是动态变化的(支持扩容)。

- ArrayList提供了更多的方法和特性,比如:addAll(),removeAll(),iterator()等等。

ArrayList与Vector区别?

- Vector是线程安全的,ArrayList不是线程安全的。其中,Vector在关键性的方法前面都加了synchronized关键字,来保证线程的安全性。如果有多个线程会访问到集合,那最好是使用 Vector,因为不需要我们自己再去考虑和编写线程安全的代码。

- ArrayList在底层数组不够用时在原来的基础上扩展0.5倍,Vector是扩展1倍,这样ArrayList就有利于节约内存空间。

说一说ArrayList的扩容机制?

ArrayList扩容的本质就是计算出新的扩容数组的size后实例化,并将原有数组内容复制到新数组中去。默认情况下,新的容量会是原容量的1.5倍。

以JDK1.8为例说明:

public boolean add(E e) {

//判断是否可以容纳e,若能,则直接添加在末尾;若不能,则进行扩容,然后再把e添加在末尾

ensureCapacityInternal(size + 1); // Increments modCount!!

//将e添加到数组末尾

elementData[size++] = e;

return true;

}

// 每次在add()一个元素时,arraylist都需要对这个list的容量进行一个判断。通过ensureCapacityInternal()方法确保当前ArrayList维护的数组具有存储新元素的能力,经过处理之后将元素存储在数组elementData的尾部

private void ensureCapacityInternal(int minCapacity) {

ensureExplicitCapacity(calculateCapacity(elementData, minCapacity));

}

private static int calculateCapacity(Object[] elementData, int minCapacity) {

//如果传入的是个空数组则最小容量取默认容量与minCapacity之间的最大值

if (elementData == DEFAULTCAPACITY_EMPTY_ELEMENTDATA) {

return Math.max(DEFAULT_CAPACITY, minCapacity);

}

return minCapacity;

}

private void ensureExplicitCapacity(int minCapacity) {

modCount++;

// 若ArrayList已有的存储能力满足最低存储要求,则返回add直接添加元素;如果最低要求的存储能力>ArrayList已有的存储能力,这就表示ArrayList的存储能力不足,因此需要调用 grow();方法进行扩容

if (minCapacity - elementData.length > 0)

grow(minCapacity);

}

private void grow(int minCapacity) {

// 获取elementData数组的内存空间长度

int oldCapacity = elementData.length;

// 扩容至原来的1.5倍

int newCapacity = oldCapacity + (oldCapacity >> 1);

//校验容量是否够

if (newCapacity - minCapacity < 0)

newCapacity = minCapacity;

//若预设值大于默认的最大值,检查是否溢出

if (newCapacity - MAX_ARRAY_SIZE > 0)

newCapacity = hugeCapacity(minCapacity);

// 调用Arrays.copyOf方法将elementData数组指向新的内存空间

//并将elementData的数据复制到新的内存空间

elementData = Arrays.copyOf(elementData, newCapacity);

}HashMap的底层数据结构是什么?

在JDK1.7 和JDK1.8 中有所差别:

在JDK1.7 中,由“数组+链表”组成,数组是 HashMap 的主体,链表则是主要为了解决哈希冲突而存在的。

在JDK1.8 中,由“数组+链表+红黑树”组成。当链表过长,则会严重影响 HashMap 的性能,红黑树搜索时间复杂度是 O(logn),而链表是糟糕的 O(n)。因此,JDK1.8 对数据结构做了进一步的优化,引入了红黑树,链表和红黑树在达到一定条件会进行转换:

当链表超过 8 且数据总量超过64才会转红黑树。

将链表转换成红黑树前会判断,如果当前数组的长度小于64,那么会选择先进行数组扩容,而不是转换为红黑树,以减少搜索时间。

解决hash冲突的办法有哪些?HashMap用的哪种?

解决Hash冲突方法有:开放定址法、再哈希法、链地址法(拉链法)、建立公共溢出区。HashMap中采用的是链地址法。

- 开放定址法也称为再散列法,基本思想就是,如果p=H(key)出现冲突时,则以p为基础,再次hash,p1=H(p),如果p1再次出现冲突,则以p1为基础,以此类推,直到找到一个不冲突的哈希地址pi。 因此开放定址法所需要的hash表的长度要大于等于所需要存放的元素,而且因为存在再次hash,所以只能在删除的节点上做标记,而不能真正删除节点。

- **再哈希法(双重散列,多重散列)**,提供多个不同的hash函数,当R1=H1(key1)发生冲突时,再计算R2=H2(key1),直到没有冲突为止。 这样做虽然不易产生堆集,但增加了计算的时间。

- **链地址法(拉链法)**,将哈希值相同的元素构成一个同义词的单链表,并将单链表的头指针存放在哈希表的第i个单元中,查找、插入和删除主要在同义词链表中进行。链表法适用于经常进行插入和删除的情况。

- 建立公共溢出区,将哈希表分为公共表和溢出表,当溢出发生时,将所有溢出数据统一放到溢出区。

HashMap和ConcurrentHashMap是选择先用链表,再转红黑树

因为红黑树需要进行左旋,右旋,变色这些操作来保持平衡,而单链表不需要。当元素小于 8 个的时候,此时做查询操作,链表结构已经能保证查询性能。当元素大于 8 个的时候, 红黑树搜索时间复杂度是 O(logn),而链表是 O(n),此时需要红黑树来加快查询速度,但是新增节点的效率变慢了。

因此,如果一开始就用红黑树结构,元素太少,新增效率又比较慢,无疑这是浪费性能的。

HashMap默认加载因子是多少?为什么是 0.75,不是 0.6 或者 0.8 ?

回答这个问题前,我们来先看下HashMap的默认构造函数:

int threshold; // 容纳键值对的最大值

final float loadFactor; // 负载因子

int modCount;

int size; Node[] table的初始化长度length(默认值是16),Load factor为负载因子(默认值是0.75),threshold是HashMap所能容纳键值对的最大值。threshold = length * Load factor。也就是说,在数组定义好长度之后,负载因子越大,所能容纳的键值对个数越多。

默认的loadFactor是0.75,0.75是对空间和时间效率的一个平衡选择,一般不要修改,除非在时间和空间比较特殊的情况下:

如果内存空间很多而又对时间效率要求很高,可以降低负载因子loadFactor的值。

相反,如果内存空间紧张而对时间效率要求不高,可以增加负载因子loadFactor的值,这个值可以大于1。

我们来追溯下作者在源码中的注释(JDK1.7):

As a general rule, the default load factor (.75) offers a good tradeoff between time and space costs. Higher values decrease the space overhead but increase the lookup cost (reflected in most of the operations of the HashMap class, including get and put). The expected number of entries in the map and its load factor should be taken into account when setting its initial capacity, so as to minimize the number of rehash operations. If the initial capacity is greater than the maximum number of entries divided by the load factor, no rehash operations will ever occur.翻译过来大概的意思是:作为一般规则,默认负载因子(0.75)在时间和空间成本上提供了很好的折衷。较高的值会降低空间开销,但提高查找成本(体现在大多数的HashMap类的操作,包括get和put)。设置初始大小时,应该考虑预计的entry数在map及其负载系数,并且尽量减少rehash操作的次数。如果初始容量大于最大条目数除以负载因子,rehash操作将不会发生。

HashMap 中 key 的存储索引是怎么计算的

首先根据key的值计算出hashcode的值,然后根据hashcode计算出hash值,最后通过hash&(length-1)计算得到存储的位置。看看源码的实现:

// jdk1.7

方法一:

static int hash(int h) {

int h = hashSeed;

if (0 != h && k instanceof String) {

return sun.misc.Hashing.stringHash32((String) k);

}

h ^= k.hashCode(); // 为第一步:取hashCode值

h ^= (h >>> 20) ^ (h >>> 12);

return h ^ (h >>> 7) ^ (h >>> 4);

}

方法二:

static int indexFor(int h, int length) { //jdk1.7的源码,jdk1.8没有这个方法,但实现原理一样

return h & (length-1); //第三步:取模运算

}// jdk1.8

static final int hash(Object key) {

int h;

return (key == null) ? 0 : (h = key.hashCode()) ^ (h >>> 16);

/*

h = key.hashCode() 为第一步:取hashCode值

h ^ (h >>> 16) 为第二步:高位参与运算

*/

}这里的 Hash 算法本质上就是三步:取key的 hashCode 值、根据 hashcode 计算出hash值、通过取模计算下标。其中,JDK1.7和1.8的不同之处,就在于第二步。我们来看下详细过程,以JDK1.8为例,n为table的长度。

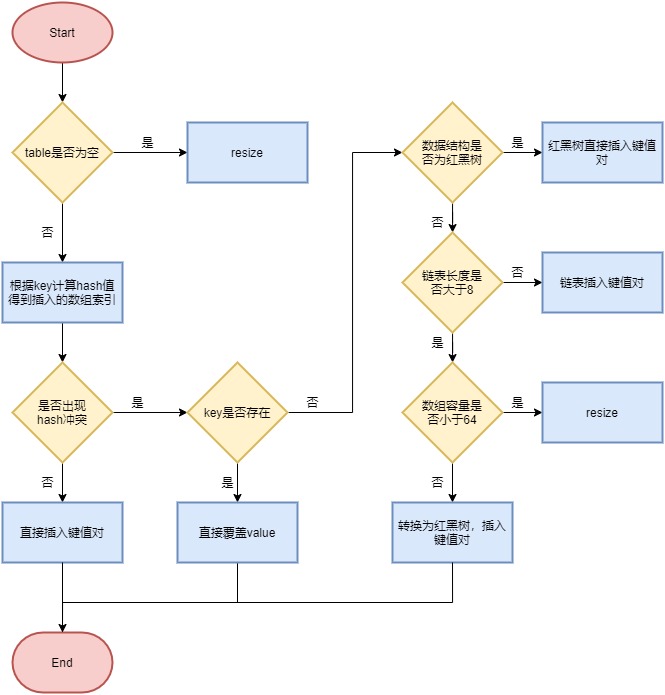

HashMap 的put方法流程

简要流程如下:

首先根据 key 的值计算 hash 值,找到该元素在数组中存储的下标;

如果数组是空的,则调用 resize 进行初始化;

如果没有哈希冲突直接放在对应的数组下标里;

如果冲突了,且 key 已经存在,就覆盖掉 value;

如果冲突后,发现该节点是红黑树,就将这个节点挂在树上;

如果冲突后是链表,判断该链表是否大于 8 ,如果大于 8 并且数组容量小于 64,就进行扩容;如果链表节点大于 8 并且数组的容量大于 64,则将这个结构转换为红黑树;否则,链表插入键值对,若 key 存在,就覆盖掉 value。

一般用什么作为HashMap的key?

一般用Integer、String 这种不可变类当 HashMap 当 key,而且 String 最为常用。

- 因为字符串是不可变的,所以在它创建的时候 hashcode 就被缓存了,不需要重新计算。这就是 HashMap 中的键往往都使用字符串的原因。

- 因为获取对象的时候要用到 equals() 和 hashCode() 方法,那么键对象正确的重写这两个方法是非常重要的,这些类已经很规范的重写了 hashCode() 以及 equals() 方法。

HashMap 的扩容方式

HashMap 在容量超过负载因子所定义的容量之后,就会扩容。Java 里的数组是无法自动扩容的,方法是将 HashMap 的大小扩大为原来数组的两倍,并将原来的对象放入新的数组中。

那扩容的具体步骤是什么?让我们看看源码。

先来看下JDK1.7 的代码:

void resize(int newCapacity) { //传入新的容量

Entry[] oldTable = table; //引用扩容前的Entry数组

int oldCapacity = oldTable.length;

if (oldCapacity == MAXIMUM_CAPACITY) { //扩容前的数组大小如果已经达到最大(2^30)了

threshold = Integer.MAX_VALUE; //修改阈值为int的最大值(2^31-1),这样以后就不会扩容了

return;

}

Entry[] newTable = new Entry[newCapacity]; //初始化一个新的Entry数组

transfer(newTable); //!!将数据转移到新的Entry数组里

table = newTable; //HashMap的table属性引用新的Entry数组

threshold = (int)(newCapacity * loadFactor);//修改阈值

}这里就是使用一个容量更大的数组来代替已有的容量小的数组,transfer()方法将原有Entry数组的元素拷贝到新的Entry数组里。

void transfer(Entry[] newTable) {

Entry[] src = table; //src引用了旧的Entry数组

int newCapacity = newTable.length;

for (int j = 0; j < src.length; j++) { //遍历旧的Entry数组

Entry<K,V> e = src[j]; //取得旧Entry数组的每个元素

if (e != null) {

src[j] = null;//释放旧Entry数组的对象引用(for循环后,旧的Entry数组不再引用任何对象)

do {

Entry<K,V> next = e.next;

int i = indexFor(e.hash, newCapacity); //!!重新计算每个元素在数组中的位置

e.next = newTable[i]; //标记[1]

newTable[i] = e; //将元素放在数组上

e = next; //访问下一个Entry链上的元素

} while (e != null);

}

}

}newTable[i] 的引用赋给了 e.next ,也就是使用了单链表的头插入方式,同一位置上新元素总会被放在链表的头部位置;这样先放在一个索引上的元素终会被放到 Entry 链的尾部(如果发生了 hash 冲突的话)。

ConcurrentHashMap 的实现原理

ConcurrentHashMap 在 JDK1.7 和 JDK1.8 的实现方式是不同的。

先来看下JDK1.7

JDK1.7中的ConcurrentHashMap 是由 Segment 数组结构和 HashEntry 数组结构组成,即ConcurrentHashMap 把哈希桶切分成小数组(Segment ),每个小数组有 n 个 HashEntry 组成。

其中,Segment 继承了 ReentrantLock,所以 Segment 是一种可重入锁,扮演锁的角色;HashEntry 用于存储键值对数据。

首先将数据分为一段一段的存储,然后给每一段数据配一把锁,当一个线程占用锁访问其中一个段数据时,其他段的数据也能被其他线程访问,能够实现真正的并发访问。

再来看下JDK1.8

在数据结构上, JDK1.8 中的ConcurrentHashMap 选择了与 HashMap 相同的数组+链表+红黑树结构;在锁的实现上,抛弃了原有的 Segment 分段锁,采用CAS + synchronized实现更加低粒度的锁。

将锁的级别控制在了更细粒度的哈希桶元素级别,也就是说只需要锁住这个链表头结点(红黑树的根节点),就不会影响其他的哈希桶元素的读写,大大提高了并发度。

JDK1.7与JDK1.8 中ConcurrentHashMap 的对比

- 数据结构: 取消了Segment分段锁的数据结构,取而代之的是数组+链表+红黑树的结构。

- 保证线程安全机制: JDK1.7采用Segment的分段锁机制实现线程安全,其中segment继承自ReentrantLock。JDK1.8 采用CAS+Synchronized保证线程安全。

- 锁的粒度: 原来是对需要进行数据操作的Segment加锁,现调整为对每个数组元素加锁(Node)。

- 链表转化为红黑树: 定位结点的hash算法简化会带来弊端,Hash冲突加剧,因此在链表节点数量大于8且数组长度大于64时,会将链表转化为红黑树进行存储。

- 查询时间复杂度: 从原来的遍历链表O(n),变成遍历红黑树O(logN)。

ConcurrentHashMap 的 put 方法执行逻辑是什么

先来看JDK1.7

首先,会尝试获取锁,如果获取失败,利用自旋获取锁;如果自旋重试的次数超过 64 次,则改为阻塞获取锁。

获取到锁后:

- 将当前 Segment 中的 table 通过 key 的 hashcode 定位到 HashEntry。

- 遍历该 HashEntry,如果不为空则判断传入的 key 和当前遍历的 key 是否相等,相等则覆盖旧的 value。

- 不为空则需要新建一个 HashEntry 并加入到 Segment 中,同时会先判断是否需要扩容。

- 释放 Segment 的锁。

再来看JDK1.8

大致可以分为以下步骤:

- 根据 key 计算出 hash值。

- 判断是否需要进行初始化。

- 定位到 Node,拿到首节点 f,判断首节点 f:

- 如果为 null ,则通过cas的方式尝试添加。

- 如果为 f.hash = MOVED = -1 ,说明其他线程在扩容,参与一起扩容。

- 如果都不满足 ,synchronized 锁住 f 节点,判断是链表还是红黑树,遍历插入。

- 当在链表长度达到8,且数组长度大于64的时候,数组扩容或者将链表转换为红黑树。

ConcurrentHashMap 的 get 方法是否要加锁,为什么?

get 方法不需要加锁。因为 Node 的元素 val 和指针 next 是用 volatile 修饰的,在多线程环境下线程A修改结点的val或者新增节点的时候是对线程B可见的。

这也是它比其他并发集合比如 Hashtable、用 Collections.synchronizedMap()包装的 HashMap 安全效率高的原因之一。

static class Node<K,V> implements Map.Entry<K,V> {

final int hash;

final K key;

//可以看到这些都用了volatile修饰

volatile V val;

volatile Node<K,V> next;

}get方法不需要加锁与volatile修饰的哈希桶有关吗?

没有关系。哈希桶table用volatile修饰主要是保证在数组扩容的时候保证可见性。

static final class Segment<K,V> extends ReentrantLock implements Serializable {

// 存放数据的桶

transient volatile HashEntry<K,V>[] table;ConcurrentHashMap 的并发度是多少

在JDK1.7中,并发度默认是16,这个值可以在构造函数中设置。如果自己设置了并发度,ConcurrentHashMap 会使用大于等于该值的最小的2的幂指数作为实际并发度,也就是比如你设置的值是17,那么实际并发度是32。

Iterator 和 ListIterator 有什么区别

遍历。使用Iterator,可以遍历所有集合,如Map,List,Set;但只能在向前方向上遍历集合中的元素。使用ListIterator,只能遍历List实现的对象,但可以向前和向后遍历集合中的元素。

添加元素。Iterator无法向集合中添加元素;而,ListIteror可以向集合添加元素。

修改元素。Iterator无法修改集合中的元素;而,ListIterator可以使用set()修改集合中的元素。

索引。Iterator无法获取集合中元素的索引;而,使用ListIterator,可以获取集合中元素的索引。

HashMap为什么线程不安全

- 多线程下扩容死循环。JDK1.7中的 HashMap 使用头插法插入元素,在多线程的环境下,扩容的时候有可能导致环形链表的出现,形成死循环。因此,JDK1.8使用尾插法插入元素,在扩容时会保持链表元素原本的顺序,不会出现环形链表的问题。

- 多线程的put可能导致元素的丢失。多线程同时执行 put 操作,如果计算出来的索引位置是相同的,那会造成前一个 key 被后一个 key 覆盖,从而导致元素的丢失。此问题在JDK 1.7和 JDK 1.8 中都存在。

- put和get并发时,可能导致get为null。线程1执行put时,因为元素个数超出threshold而导致rehash,线程2此时执行get,有可能导致这个问题。此问题在JDK 1.7和 JDK 1.8 中都存在。

ConcurrentHashMap 不支持 key 或者 value 为 null 的原因?

我们先来说value 为什么不能为 null ,因为ConcurrentHashMap是用于多线程的 ,如果map.get(key)得到了 null ,无法判断,是映射的value是 null ,还是没有找到对应的key而为 null ,这就有了二义性。

而用于单线程状态的HashMap却可以用containsKey(key) 去判断到底是否包含了这个 null 。

我们用反证法来推理:

假设ConcurrentHashMap 允许存放值为 null 的value,这时有A、B两个线程,线程A调用ConcurrentHashMap.get(key)方法,返回为 null ,我们不知道这个 null 是没有映射的 null ,还是存的值就是 null 。

假设此时,返回为 null 的真实情况是没有找到对应的key。那么,我们可以用ConcurrentHashMap .containsKey(key)来验证我们的假设是否成立,我们期望的结果是返回false。

但是在我们调用ConcurrentHashMap .get(key)方法之后,containsKey方法之前,线程B执行了ConcurrentHashMap .put(key, null )的操作。那么我们调用containsKey方法返回的就是true了,这就与我们的假设的真实情况不符合了,这就有了二义性。

至于ConcurrentHashMap 中的key为什么也不能为 null 的问题,源码就是这样写的,哈哈。如果面试官不满意,就回答因为作者Doug不喜欢 null ,所以在设计之初就不允许了 null 的key存在。

ConcurrentHashMap 和 Hashtable 的效率哪个更高?为什么?

ConcurrentHashMap 的效率要高于Hashtable,因为Hashtable给整个哈希表加了一把大锁从而实现线程安全。而ConcurrentHashMap 的锁粒度更小,在JDK1.7中采用分段锁实现线程安全,在JDK1.8 中采用CAS+Synchronized实现线程安全。

说一下Hashtable的锁机制

Hashtable是使用Synchronized来实现线程安全的,给整个哈希表加了一把大锁,多线程访问时候,只要有一个线程访问或操作该对象,那其他线程只能阻塞等待需要的锁被释放,在竞争激烈的多线程场景中性能就会非常差!

多线程下安全的操作 map 还有其他方法吗?

还可以使用Collections.synchronizedMap方法,对方法进行加同步锁

private static class SynchronizedMap<K,V>

implements Map<K,V>, Serializable {

private static final long serialVersionUID = 1978198479659022715L;

private final Map<K,V> m; // Backing Map

final Object mutex; // Object on which to synchronize

SynchronizedMap(Map<K,V> m) {

this.m = Objects.requireNon null (m);

mutex = this;

}

SynchronizedMap(Map<K,V> m, Object mutex) {

this.m = m;

this.mutex = mutex;

}

// 省略部分代码

}如果传入的是 HashMap 对象,其实也是对 HashMap 做的方法做了一层包装,里面使用对象锁来保证多线程场景下,线程安全,本质也是对 HashMap 进行全表锁。在竞争激烈的多线程环境下性能依然也非常差,不推荐使用!

HashSet 和 HashMap 区别?

补充HashSet的实现:HashSet的底层其实就是HashMap,只不过我们HashSet是实现了Set接口并且把数据作为K值,而V值一直使用一个相同的虚值来保存。如源码所示:

public boolean add(E e) {

return map.put(e, PRESENT)==null;// 调用HashMap的put方法,PRESENT是一个至始至终都相同的虚值

}由于HashMap的K值本身就不允许重复,并且在HashMap中如果K/V相同时,会用新的V覆盖掉旧的V,然后返回旧的V,那么在HashSet中执行这一句话始终会返回一个false,导致插入失败,这样就保证了数据的不可重复性。

Collection框架中实现比较要怎么做?

第一种,实体类实现Comparable接口,并实现 compareTo(T t) 方法,称为内部比较器。

第二种,创建一个外部比较器,这个外部比较器要实现Comparator接口的 compare(T t1, T t2)方法。

讲一讲快速失败(fail-fast)和安全失败(fail-safe)

快速失败(fail—fast)

在用迭代器遍历一个集合对象时,如果遍历过程中对集合对象的内容进行了修改(增加、删除、修改),则会抛出Concurrent Modification Exception。

原理:

迭代器在遍历时直接访问集合中的内容,并且在遍历过程中使用一个 modCount 变量。集合在被遍历期间如果内容发生变化,就会改变modCount的值。每当迭代器使用hashNext()/next()遍历下一个元素之前,都会检测modCount变量是否为expectedmodCount值,是的话就返回遍历;否则抛出异常,终止遍历。

注意:

这里异常的抛出条件是检测到 modCount!=expectedmodCount 这个条件。如果集合发生变化时修改modCount值刚好又设置为了expectedmodCount值,则异常不会抛出。因此,不能依赖于这个异常是否抛出而进行并发操作的编程,这个异常只建议用于检测并发修改的bug。

场景:

java.util包下的集合类都是快速失败的,不能在多线程下发生并发修改(迭代过程中被修改),比如HashMap、ArrayList 这些集合类。

安全失败(fail—safe)

采用安全失败机制的集合容器,在遍历时不是直接在集合内容上访问的,而是先复制原有集合内容,在拷贝的集合上进行遍历。

原理:

由于迭代时是对原集合的拷贝进行遍历,所以在遍历过程中对原集合所作的修改并不能被迭代器检测到,所以不会触发Concurrent Modification Exception。

缺点:

基于拷贝内容的优点是避免了ConcurrentModificationException,但同样地,迭代器并不能访问到修改后的内容,即:迭代器遍历的是开始遍历那一刻拿到的集合拷贝,在遍历期间原集合发生的修改迭代器是不知道的。

场景:

J.U.C包下的容器都是安全失败,可以在多线程下并发使用,并发修改,比如:ConcurrentHashMap。

2. JVM篇

JVM系列文章:Java虚拟机

什么是JVM内存结构?

JVM将虚拟机分为5大区域,程序计数器、虚拟机栈、本地方法栈、java堆、方法区:

- 程序计数器:线程私有的,是一块很小的内存空间,作为当前线程的行号指示器,用于记录当前虚拟机正在执行的线程指令地址;

- 虚拟机栈:线程私有的,每个方法执行的时候都会创建一个栈帧,用于存储局部变量表、操作数、动态链接和方法返回等信息,当线程请求的栈深度超过了虚拟机允许的最大深度时,就会抛出StackOverFlowError;

- 本地方法栈:线程私有的,保存的是native方法的信息,当一个jvm创建的线程调用native方法后,jvm不会在虚拟机栈中为该线程创建栈帧,而是简单的动态链接并直接调用该方法;

- 堆:java堆是所有线程共享的一块内存,几乎所有对象的实例和数组都要在堆上分配内存,因此该区域经常发生垃圾回收的操作;

- 方法区:存放已被加载的类信息、常量、静态变量、即时编译器编译后的代码数据。即永久代,在jdk1.8中不存在方法区了,被元数据区替代了,原方法区被分成两部分;1:加载的类信息;2:运行时常量池;加载的类信息被保存在元数据区中,运行时常量池保存在堆中。

什么是Java内存模型?

Java 内存模型(下文简称 JMM)就是在底层处理器内存模型的基础上,定义自己的多线程语义。它明确指定了一组排序规则,来保证线程间的可见性。

这一组规则被称为 Happens-Before, JMM 规定,要想保证 B 操作能够看到 A 操作的结果(无论它们是否在同一个线程),那么 A 和 B 之间必须满足 Happens-Before 关系:

- 单线程规则:一个线程中的每个动作都 happens-before 该线程中后续的每个动作

- 监视器锁定规则:监听器的解锁动作 happens-before 后续对这个监听器的锁定动作

- volatile 变量规则:对 volatile 字段的写入动作 happens-before 后续对这个字段的每个读取动作

- 线程 start 规则:线程 start() 方法的执行 happens-before 一个启动线程内的任意动作

- 线程 join 规则:一个线程内的所有动作 happens-before 任意其他线程在该线程 join() 成功返回之前

- 传递性:如果 A happens-before B, 且 B happens-before C, 那么 A happens-before C

怎么理解 happens-before 呢?如果按字面意思,比如第二个规则,线程(不管是不是同一个)的解锁动作发生在锁定之前?这明显不对。happens-before 也是为了保证可见性,比如那个解锁和加锁的动作,可以这样理解,线程1释放锁退出同步块,线程2加锁进入同步块,那么线程2就能看见线程1对共享对象修改的结果。

Java 提供了几种语言结构,包括 volatile, final 和 synchronized, 它们旨在帮助程序员向编译器描述程序的并发要求,其中:

- volatile - 保证可见性和有序性

- synchronized - 保证可见性和有序性; 通过管程(Monitor)保证一组动作的原子性

- final - 通过禁止在构造函数初始化和给 final 字段赋值这两个动作的重排序,保证可见性(如果 this 引用逃逸就不好说可见性了)

编译器在遇到这些关键字时,会插入相应的内存屏障,保证语义的正确性。

有一点需要注意的是,synchronized 不保证同步块内的代码禁止重排序,因为它通过锁保证同一时刻只有一个线程访问同步块(或临界区),也就是说同步块的代码只需满足 as-if-serial 语义 - 只要单线程的执行结果不改变,可以进行重排序。

所以说,Java 内存模型描述的是多线程对共享内存修改后彼此之间的可见性,另外,还确保正确同步的 Java 代码可以在不同体系结构的处理器上正确运行。

heap 和stack 有什么区别?

- 申请方式

stack:由系统自动分配。例如,声明在函数中一个局部变量 int b; 系统自动在栈中为 b 开辟空间

heap:需要程序员自己申请,并指明大小,在 c 中 malloc 函数,对于Java 需要手动 new Object()的形式开辟

- 申请后系统的响应

stack:只要栈的剩余空间大于所申请空间,系统将为程序提供内存,否则将报异常提示栈溢出。

heap:首先应该知道操作系统有一个记录空闲内存地址的链表,当系统收到程序的申请时,会遍历该链表,寻找第一个空间大于所申请空间的堆结点,然后将该结点从空闲结点链表中删除,并将该结点的空间分配给程序。另外,由于找到的堆结点的大小不一定正好等于申请的大小,系统会自动的将多余的那部分重新放入空闲链表中。

- 申请大小的限制

stack:栈是向低地址扩展的数据结构,是一块连续的内存的区域。这句话的意思是栈顶的地址和栈的最大容量是系统预先规定好的,在 WINDOWS 下,栈的大小是 2M(默认值也取决于虚拟内存的大小),如果申请的空间超过栈的剩余空间时,将提示 overflow。因此,能从栈获得的空间较小。

heap:堆是向高地址扩展的数据结构,是不连续的内存区域。这是由于系统是用链表来存储的空闲内存地址的, 自然是不连续的,而链表的遍历方向是由低地址向高地址。堆的大小受限于计算机系统中有效的虚拟内存。由此可见, 堆获得的空间比较灵活,也比较大。

- 申请效率的比较

stack:由系统自动分配,速度较快。但程序员是无法控制的。

heap:由 new 分配的内存,一般速度比较慢,而且容易产生内存碎片,不过用起来最方便。

- heap和stack中的存储内容

stack:在函数调用时,第一个进栈的是主函数中后的下一条指令(函数调用语句的下一条可执行语句)的地址, 然后是函数的各个参数,在大多数的 C 编译器中,参数是由右往左入栈的,然后是函数中的局部变量。注意静态变量是不入栈的。

当本次函数调用结束后,局部变量先出栈,然后是参数,最后栈顶指针指向最开始存的地址,也就是主函数中的下一条指令,程序由该点继续运行。

heap:一般是在堆的头部用一个字节存放堆的大小。堆中的具体内容由程序员安排。

谈谈对 OOM 的认识?如何排查 OOM 的问题?

除了程序计数器,其他内存区域都有 OOM 的风险。

- 栈一般经常会发生 StackOverflowError,比如 32 位的 windows 系统单进程限制 2G 内存,无限创建线程就会发生栈的 OOM

- Java 8 常量池移到堆中,溢出会出 java.lang.OutOfMemoryError: Java heap space,设置最大元空间大小参数无效;

- 堆内存溢出,报错同上,这种比较好理解,GC 之后无法在堆中申请内存创建对象就会报错;

- 方法区 OOM,经常会遇到的是动态生成大量的类、jsp 等;

- 直接内存 OOM,涉及到 -XX:MaxDirectMemorySize 参数和 Unsafe 对象对内存的申请。

排查 OOM 的方法:

- 增加两个参数

-XX:+HeapDumpOnOutOfMemoryError -XX:HeapDumpPath=/tmp/heapdump.hprof,当 OOM 发生时自动 dump 堆内存信息到指定目录; - 同时 jstat 查看监控 JVM 的内存和 GC 情况,先观察问题大概出在什么区域;

- 使用 MAT 工具载入到 dump 文件,分析大对象的占用情况,比如 HashMap 做缓存未清理,时间长了就会内存溢出,可以把改为弱引用 。

谈谈 JVM 中的常量池?

JVM常量池主要分为Class文件常量池、运行时常量池,全局字符串常量池,以及基本类型包装类对象常量池。

- Class文件常量池。class文件是一组以字节为单位的二进制数据流,在java代码的编译期间,我们编写的java文件就被编译为.class文件格式的二进制数据存放在磁盘中,其中就包括class文件常量池。

- 运行时常量池:运行时常量池相对于class常量池一大特征就是具有动态性,java规范并不要求常量只能在运行时才产生,也就是说运行时常量池的内容并不全部来自class常量池,在运行时可以通过代码生成常量并将其放入运行时常量池中,这种特性被用的最多的就是String.intern()。

- 全局字符串常量池:字符串常量池是JVM所维护的一个字符串实例的引用表,在HotSpot VM中,它是一个叫做StringTable的全局表。在字符串常量池中维护的是字符串实例的引用,底层C++实现就是一个Hashtable。这些被维护的引用所指的字符串实例,被称作”被驻留的字符串”或”interned string”或通常所说的”进入了字符串常量池的字符串”。

- 基本类型包装类对象常量池:java中基本类型的包装类的大部分都实现了常量池技术,这些类是Byte,Short,Integer,Long,Character,Boolean,另外两种浮点数类型的包装类则没有实现。另外上面这5种整型的包装类也只是在对应值小于等于127时才可使用对象池,也即对象不负责创建和管理大于127的这些类的对象。

OOM和SOF在什么情况下会引起

OOM(OutOfMemoryError异常)

除了程序计数器外,虚拟机内存的其他几个运行是区域都有发生OutOfMemoryError(OOM)异常的可能。

Java Heap 溢出

一般的异常信息:java.lang.OutOfMemoryError:Java heap spacess

Java堆用于存储对象实例,我们只要不断的创建对象,并且保证GC Roots到对象之间有可达路径来避免垃圾回收机制清除对象,就会在对象数量达到最大堆容量限制后产生内存溢出异常。

出现这种异常,一般手段是先通过内存映像分析工具对dump出来的堆转存快照进行分析,重点是确认内存中的对象是否是必要的,先分清是因为内存泄漏还是内存溢出引起的。

如果是内存泄漏,可进一步通过工具查看泄漏对象到GC Roots的应用链。于是就能找到泄漏对象是通过怎样的路径与GC Roots相关联并导致垃圾收集器无法自动回收。

如果不存在泄漏,那几应该检查虚拟机的参数(-Xmx和-Xms)的设置是否适当。

虚拟机栈和本地方法栈溢出

- 如果线程请求的栈深度大于虚拟机所允许的最大深度,将抛出StackOverflowError异常;

- 如果虚拟机在拓展栈时无法申请到足够的内存空间,则抛出OutOfMemoryError异常;

- 如果虚拟机栈在配置的时候指定不可拓展。就不会存在虚拟机栈拓展请求内存空调的操作,因此就不会出现OutOfMemoryError异常,只会是StackOverflowError异常。

运行时常量池异常

异常信息:java.lang.OutOfMemoryError:PermGenspace

如果要想运行时常量池中添加内容,最简单的做法就是使用String.intern()这个Native方法。该方法的作用是:

如果常量池中已经包含一个等于此String的字符串,则返回代表池中这个字符串的String对象;否则,将此String对象包含的字符串添加到常量池中,并且返回此String对象的应用。由于常量池分配在方法区中。我们可以通过-XX:PermSize和-XX:MaxPermSize限制方法区的大小,从而间接限制其中常量池的容量。

方法区溢出

异常信息:java.lang.OutOfMemoryError:PermGenspace

方法区用于存放Class的相关信息,如类名、访问修饰符、常量池、字段描述、方法描述等。也有可能是方法区中保存的class对象没有被及时回收掉或者class信息占用的内存超过了我们的配置。

方法区溢出也是一种常见的内存溢出异常,一个类如果要被垃圾收集器回收,判定条件是很苛刻的。在经常动态生成大量class的应用中,要特别注意这点。

SOF(堆栈溢出StackOverflowError)

当应用程序递归太深而发生堆栈溢出时,抛出该错误。

因为栈空间是有限的,一旦出现死循环或者是大量的递归调用,在不断的压栈过程中,造成栈容量不能满足需求而导致溢出。

栈溢出的原因:递归调用、大量循环或者死循环,全局变量是否过多,数组、List、Map数据过大。

JVM内存模型简介

JVM定义了不同原型时数据区,他们是用来执行应用程序的。某些区域随着JVM启动及销毁,另外一些区域的数据是线程性独立的,随着线程创建和销毁。JVM内存模型总体架构图如下:(来自官网)

JVM在执行Java程序时,会把它管理的内存划分为若干个区域,每个区域都有自己的用户和创建销毁时间。主要分为两个大部分,线程私有区和共享区。

线程私有区

程序计数器

当同时进行的线程数超过CPU数或其内核数时,就要通过时间片轮询分派CPU的时间资源,会发生线程切换。这时,每个线程就需要一个数据自己的计数器来记录下一条要运行的指令。如果执行的是Java方法,计数器记录正在执行的Java字节码地址。如果执行的是native本地方法,则计数器为空。

虚拟机栈

线程私有,随线程创建而创建。管理Java方法执行的内存模型。每个方法执行时都会创建一个栈帧来存储方法的变量表、操作数栈、动态链接方法、返回值、返回地址等信息。栈的大小决定了方法调用的可达深度(可通过-Xss参数设置虚拟机栈大小)。栈的大小可以是固定的,或者是动态拓展的。如果请求的栈深度大于最大可用深度,则抛出StackOverflowError;如果栈是可动态拓展的,单没有内存空间支持拓展,则抛出OutOfMemoryError。

本地方法栈

与虚拟机栈作用相似,但它不是为Java方法服务的,而是本地方法(C语言)。

线程共享区

方法区

线程共享的,用于存放被虚拟机加载的类的元数据信息,如常量、静态变量和即时编译器编译后的代码。若要分代,算是永久代。另外运行时常量池存放编译生成的各种常量。(Hotspot虚拟机确认一个类的定义信息不会被使用,也会将其回收。回收的基本条件至少有:所有该类的实例被回收,而且装载该类的ClassLoader被回收)

堆

存放对象实例和数组,是垃圾回收的主要区域,分为新生代和老年代。刚创建的对象在新生代的Eden区中,经过GC后进入新生代的S0区中,再经过GC进入新生代的S1区中,15次GC后仍存在就进入老年代。这是按照一种回收机制进行划分的,不是固定的。若堆的控件不够实例分配,则会出现OutOfMemoryError错误。

堆和栈的区别

栈是运行时单位,代表着逻辑,内含基本数据类型和堆中对象引用,所在区域连续,没有碎片;堆是存储单位,代表着数据,可被多个栈共享(包括成员中基本数据类型、引用和引用对象),所在区域不连续,会有碎片。

功能不同

栈内存用来存储局部变量和方法调用,而堆内存用来存储Java中的对象。无论是成员变量,局部变量,还是类变量,它们指向的对象都存储在堆内存中。

共享性不同

栈内存是线程私有的。 堆内存是所有线程共有的。

异常错误不同

如果栈内存或者堆内存不足都会抛出异常。 栈空间不足:StackOverFlowError或者OutOfMemoryError。 堆空间不足:OutOfMemoryError。

空间大小

栈的空间大小远远小于堆的。

对象的分配规则

对象优先分配在Eden区,如果Eden区没有足够的空间时,虚拟机执行一次Minor GC;

- 大对象直接进入老年代(大对象是指需要大量连续内存空间的对象) ,这样做的目的是避免在Eden区和两个Survivor区之间发生大量的内存拷贝(新生代采用复制算法收集内存)。

- 长期存活的对象进入老年代 ,虚拟机为每个对象定义了一个年龄计数器,如果对象经过了1次Minor GC那么对象会进入Survivor区,之后每经过一次Minor GC那么对象的年龄加1,直到达到阀值对象进入老年代。(默认年龄阈值是15)

- 动态判断对象的年龄 ,如果Survivor区中相同年龄的所有对象大小的总和大于Survivor空间的一半,年龄大于或等于该年龄的对象可以直接进入老年代。

- 空间分配担保 ,每次进行Minor GC时,JVM会计算Survivor区移至老年区的对象的平均大小,如果这个值大于老年区的剩余值大小则进行一次Full GC,如果小于,则检查HandlePromotionFailure设置,如果true则只进行Minor GC,如果false则进行Full GC。

JVM加载class文件的原理机制

JVM中类的装载是由类加载器(ClassLoader)和它的子类来实现的,Java中的类加载器是一个重要的Java运行时系统组件,它负责在运行时查找和装入类文件中的类。 由于Java的跨平台性,经过编译的Java源程序并不是一个可执行程序,而是一个或多个类文件。当Java程序需要使用某个类时,JVM会确保这个类已经被加载、连接(验证、准备和解析)和初始化。类的加载是指把类的.class文件中的数据读入到内存中,通常是创建一个字节数组读入.class文件,然后产生与所加载类对应的Class对象。加载完成后,Class对象还不完整,所以此时的类还不可用。当类被加载后就进入连接阶段,这一阶段包括验证、准备(为静态变量分配内存并设置默认的初始值)和解析(将符号引用替换为直接引用)三个步骤。最后JVM对类进行初始化。

初始化内容

- 如果类存在直接的父类并且这个类还没有被初始化,那么就先初始化父类;

- 如果类中存在初始化语句,就依次执行这些初始化语句。 类的加载是由类加载器完成的。

类加载器分类

类加载器包括:根加载器(BootStrap)、扩展加载器(Extension)、系统加载器(System)和用户自定义类加载器(java.lang.ClassLoader的子类)。类加载过程采取了双亲委托机制(PDM)。PDM更好的保证了Java平台的安全性,在该机制中,JVM自带的Bootstrap是根加载器,其他的加载器都有且仅有一个父类加载器。类的加载首先请求父类加载器加载,父类加载器无能为力时才由其子类加载器自行加载。JVM不会向Java程序提供对Bootstrap的引用。下面是关于几个类加载器的说明:

- Bootstrap:一般用本地代码实现,负责加载JVM基础核心类库(rt.jar);

- Extension:从java.ext.dirs系统属性所指定的目录中加载类库,它的父加载器是Bootstrap;

- System:又叫应用类加载器,其父类是Extension。它是应用最广泛的类加载器。它从环境变量classpath或者系统属性java.class.path所指定的目录中记载类,是用户自定义加载器的默认父加载器。

类的生命周期

类的生命周期包括这几个部分,加载、连接、初始化、使用和卸载,其中前三部是类的加载的过程,如下图:

- 加载:查找并加载类的二进制数据,在Java堆中也创建一个java.lang.Class类的对象;

- 连接:连接又包含三块内容:验证、准备、初始化;

- 验证,文件格式、元数据、字节码、符号引用验证;

- 准备,为类的静态变量分配内存,并将其初始化为默认值,如果类变量被final修饰,不会设置初始值,而是将其进行实际赋值;

- 解析,把类中的符号引用转换为直接引用(换句话说,解析是在引用转换的时候触发,无转换无解析)。

- 初始化:为类的静态变量赋予正确的初始值(初始化过程是单线程的,如果存在多线程,由一个线程执行,其他线程自旋);

- 使用:new出对象程序中使用;

- 卸载:执行垃圾回收。

Java的对象结构

Java对象由三个部分组成:对象头、实例数据、对齐填充。

对象头: 由两部分组成,第一部分存储对象自身的运行时数据:哈希码、GC分代年龄、锁标识状态、线程持有的锁、偏向线程ID(一般占32/64 bit)。第二部分是指针类型,指向对象的类元数据类型(即对象代表哪个类)。如果是数组对象,则对象头中还有一部分用来记录数组长度。

实例数据: 用来存储对象真正的有效信息(包括父类继承下来的和自己定义的)。

对齐填充: JVM要求对象起始地址必须是8字节的整数倍(8字节对齐)。

如何判断对象可以被回收

判断对象是否存活一般有两种方式:

- 引用计数:每个对象有一个引用计数属性,新增一个引用时计数加1,引用释放时计数减1,计数为0时可以回收。此方法简单,无法解决对象相互循环引用的问题;(对象的循环引用会引发内存的泄露问题)

- 可达性分析(Reachability Analysis):从GC Roots开始向下搜索,搜索所走过的路径称为引用链。当一个对象到GC Roots没有任何引用链相连时,则证明此对象是不可用的,不可达对象。

在可达性分析算法和引用计数法中被标记的对象就一定会被回收吗

不一定,此两种算法标记这些可被回收对象后,虚拟机会对其进行最后的判定。

- 首先判定当前对象是否有必要执行finalize方法,即这个类有没有重写finalize方法;

- 如果没有重写,则最终判定此对象死亡;

- 如果重写,会判定此方法是否已经被JVM执行过,如果执行过,则被判定为对象死亡;

- 如果没有执行,会将对象加入到F-Queue队列中,JVM会自动创建低优先级的Finalizer线程去执行F-Queue队列中的对象;

- 如果此对象的finalize方法中重新与引用链上的对象关联,就可以不被回收,获得重生,否则被判定为对象死亡。

需要注意:

- finalize方法如果存在死循环或者其他复杂逻辑,会导致F-Queue队列其他对象永久等待,会导致内存回收系统崩溃,JVM不保证等待finalize方法执行结束;

- finalize方法运行代价较高,不确定性大,不建议使用该方法。

垃圾收集算法

GC最基础的算法有标记清除法、标记整理法、复制算法、分代收集算法,我们常用的垃圾回收器一般都采用分代收集算法。

标记-清除算法

步骤:

- 第一步:利用可达性去遍历内存,把存活对象和垃圾对象进行标记;

- 第二步:在遍历一遍,将所有标记的对象回收掉。

特点:

效率不行,标记和清除的效率都不高;标记和清除后会产生大量的不连续的空间分片,可能会导致之后程序运行的时候需分配大对象而找不到连续分片而不得不触发一次GC。

标记-整理法

步骤:

- 第一步:利用可达性去遍历内存,把存活对象和垃圾对象进行标记;

- 第二步:将所有的存活的对象向一端移动,将端边界以外的对象都回收掉;

特点:

适用于存活对象多,垃圾少的情况;需要整理的过程,无空间碎片产生。

复制算法

将内存按照容量大小分为大小相等的两块,每次只使用一块,当一块使用完了,就将还存活的对象移到另一块上,然后在把使用过的内存空间移除。

特点:

不会产生空间碎片;内存使用率极低。

分代收集算法

根据内存对象的存活周期不同,将内存划分成几块,java虚拟机一般将内存分成新生代和老生代,在新生代中,有大量对象死去和少量对象存活,所以采用复制算法,只需要付出少量存活对象的复制成本就可以完成收集;老年代中因为对象的存活率高,没有额外的空间对他进行分配担保,所以采用标记清理或者标记整理算法进行回收。

对比

JVM调优命令有哪些

Sun JDK监控和故障处理命令有jps 、jstat 、jmap 、jhat 、jstack 、jinfo。

jps

JVM Process Status Tool,显示指定系统内所有的HotSpot虚拟机进程。

命令格式:jps [options] [hostid]

-l:输出应用程序main class的完整package名或者应用程序的jar文件完整路径名;-m:输出传递给main方法的参数,在嵌入式jvm上可能是null;-v:输出传递给JVM的参数;-V:隐藏传递给JVM的参数;-p:只显示pid,不显示class名称、jar名和传递给main方法的参数。

jstat

JVM statistics Monitoring是用于监视虚拟机运行时状态信息的命令,它可以显示出虚拟机进程中的类装载、内存、垃圾收集、JIT编译等运行数据。

命令格式:jstat [options vmid [interval[s|ms] [count]]]

-class:显示类装载、卸载数量、总空间以及类装载所消耗的时间;-compiler:显示JIT编译的相关信息;-gc:显示和GC相关的堆和方法区信息;-gcapacity:显示各个代的容量以及使用情况;-gcmetacapacity:显示metaspace的大小和使用情况;-gcnew:显示新生代的信息;-gcold:显示老年代和永久代(元数据区)的信息;-gcoldcapacity:显示老年代的信息;-gcutil:显示垃圾收集信息;-gccause:显示垃圾回收的相关信息;-printcompilation:输出JIT编译的方法信息

jmap

JVM Memory Map命令用于生成heap dump文件。

命令格式:jmap [option] vmid

[pid]:查看进程的内存映像信息;-heap:显示Java堆详细信息;-histo:显示堆中对象的统计信息,包括类、实例数量、合计数量;-clstats:打印类加载器信息;-finalizerinfo:显示在F-Queue队列等待Finalizer线程执行finalizer方法的对象;-dump:生成堆转储快照。(jmap -dump:file=filename,format=b)

jhat

JVM Heap Analysis Tool命令是与jmap搭配使用,用来分析jmap生成的dump,jhat内置了一个微型的HTTP/HTML服务器,生成dump的分析结果后,可以在浏览器中查看。

命令:jhat [filename]

此命令一般不会使用的原因:

- 在生产导出日志文件后,直接在生产服务器中分析日志对性能消耗较大;

- 将日志放到本地分析,有更多的优秀日志分析工具替代jhat。

jstack

用于生成java虚拟机当前时刻的线程快照。

命令格式:jstack [option] vmid

-l:打印关于锁的附加信息,例如java.util.concurrent的ownable synchronizer列表打印的是运行中的栈信息;-F -l:和jstack -l相对应,打印的是挂起的栈信息(如死锁);-m:打印java和native c/C++框架的所有栈信息。

jinfo

JVM Configuration info 这个命令作用是实时查看和调整虚拟机运行参数。

命令格式:jinfo [option] <name> vmid

[pid]:输出全部的参数和系统属性;-flag name:输出对应名称的参数;-flag [+|-]name:开启或者关闭对应名称的参数;-flag name=value:设定对应名称的参数;-flags:输出全部的参数;-sysprops:输出系统属性,和System.getProperties()方法获取的相同。

常用的调优工具有哪些

常用调优工具分为两类,jdk自带监控工具:jconsole和jvisualvm,第三方有:MAT(MemoryAnalyzer Tool)、GChisto。

- jconsole,Java Monitoring and Management Console是从java5开始,在JDK中自带的java监控和管理控制台,用于对JVM中内存,线程和类等的监控;

- VisualVM,jdk自带全能工具,可以分析内存快照、线程快照;监控内存变化、GC变化等;

- MAT,Memory Analyzer Tool,一个基于Eclipse的内存分析工具,是一个快速、功能丰富的Java heap分析工具,它可以帮助我们查找内存泄漏和减少内存消耗;

- GChisto,一款专业分析gc日志的工具。

JVM常用的性能调优的参数有哪些

设定堆内存大小

-Xmx:堆内存最大限制;-Xms:堆内存的初始大小

设定新生代大小

新生代不宜太小,否则会出现频繁的Minor GC,不断刷新对象进入老年代,一般新生代占堆内存的2/8为宜,也是官方推荐的比率。

-XX:NewSize:新生代大小;-XX:NewRatio:新生代和老生代占比;-XX:SurvivorRatio:伊甸园空间和幸存者空间的占比(一般不设置,采用默认的8:1即可)

设定垃圾回收器

- 年轻代用

-XX:+UseParNewGC(ParNew GC是以低延迟为核心,注重的是应用系统,提高用户的使用体验,Parallel Scavenge是注重吞吐量,主要是计算型的服务使用) - 年老代用

-XX:+UseConcMarkSweepGC

对象一定分配在堆内吗,为什么?

对象不是一定分配在堆内的,Java通过逃逸分析,那些逃不出方法的对象会在栈上分配。

逃逸分析

逃逸分析(Escape Analysis),是一种可以有效减少Java 程序中同步负载和内存堆分配压力的跨函数全局数据流分析算法。通过逃逸分析,Java Hotspot编译器能够分析出一个新的对象的引用的使用范围,从而决定是否要将这个对象分配到堆上。

逃逸分析的好处

- 栈上分配:可以降低垃圾收集器运行的频率;

- 同步消除:如果发现某个对象只能从一个线程可访问,那么在这个对象上的操作可以不需要同步;

- 标量替换:把对象分解成一个个基本类型,并且内存分配不再是分配在堆上,而是分配在栈上。这样的好处有,第一减少内存使用,因为不用生成对象头。第二程序内存回收效率高,并且GC频率也会减少。

详细内容文章

Java的即时编译(Just In Time, JIT)及其优化

什么是Stop The world?什么是OopMap?什么是安全点?

进行垃圾回收的过程中,会涉及对象的移动。为了保证对象引用更新的正确性,必须暂停所有的用户线程,像这样的停顿,虚拟机设计者形象描述为Stop The World。也简称为STW。

在HotSpot中,有个数据结构(映射表)称为OopMap。一旦类加载动作完成的时候,HotSpot就会把对象内什么偏移量上是什么类型的数据计算出来,记录到OopMap。在即时编译过程中,也会在特定的位置生成 OopMap,记录下栈上和寄存器里哪些位置是引用。

这些特定的位置主要在:

- 循环的末尾(非 counted 循环)

- 方法临返回前 / 调用方法的call指令后

- 可能抛异常的位置

这些位置就叫作安全点(safepoint)。用户程序执行时并非在代码指令流的任意位置都能够在停顿下来开始垃圾收集,而是必须是执行到安全点才能够暂停。

安全点、安全区域和中断方式

在Stop The World的时候,会涉及安全点、安全区域以及中断方式的概念。

安全点(safe point)

- HotSpot通过OoMap来记录安全点,安全点是定在指令上,但不是每一条指令都可以作为安全点;

- 当指令让程序运行时间较长,此指令不会被定为安全点。

安全区域(safe region)

- 存在sleep或者blocked状态的线程无法响应JVM中断请求;

- 在此区域中引用关系不会发生变化,可以安全进行GC。

中断方式

- 抢先式中断:不需要线程执行代码主动配合,直接中断全部线程,如果线程执行在非安全点位置,等待其执行到安全点后中断;

- 主动式中断:需要线程执行代码主动配合,GC开始时设置一个标志,每个线程主动轮询标志,发现标志为true,主动中断,轮询的动作是在线程执行到每个安全点时触发。

指针碰撞和空闲列表

指针碰撞

一般情况下,JVM的对象都放在堆内存中(发生逃逸分析除外)。当类加载检查通过后,Java虚拟机开始为新生对象分配内存。如果Java堆中内存是绝对规整的,所有被使用过的的内存都被放到一边,空闲的内存放到另外一边,中间放着一个指针作为分界点的指示器,所分配内存仅仅是把那个指针向空闲空间方向挪动一段与对象大小相等的实例,这种分配方式就是指针碰撞。

空闲列表

如果Java堆内存中的内存并不是规整的,已被使用的内存和空闲的内存相互交错在一起,不可以进行指针碰撞了,虚拟机必须维护一个列表,记录哪些内存是可用的,在分配的时候从列表找到一块大小匹配的空间分配给对象实例,并更新列表上的记录,这种分配方式就是空闲列表。

如何判断一个对象是否存活?

判断一个对象是否存活,分为两种算法1:引用计数法;2:可达性分析算法;

引用计数法

给每一个对象设置一个引用计数器,当有一个地方引用该对象的时候,引用计数器就+1,引用失效时,引用计数器就-1;当引用计数器为0的时候,就说明这个对象没有被引用,也就是垃圾对象,等待回收;

缺点:无法解决循环引用的问题,当A引用B,B也引用A的时候,此时AB对象的引用都不为0,此时也就无法垃圾回收,所以一般主流虚拟机都不采用这个方法。(容易导致内存泄漏问题)

可达性分析法

从一个被称为GC Roots的对象向下搜索,如果一个对象到GC Roots没有任何引用链相连接时,说明此对象不可用,在java中可以作为GC Roots的对象有以下几种:

- 虚拟机栈中引用的对象

- 方法区类静态属性引用的变量

- 方法区常量池引用的对象

- 本地方法栈JNI引用的对象

但一个对象满足上述条件的时候,不会马上被回收,还需要进行两次标记;第一次标记:判断当前对象是否有finalize()方法并且该方法没有被执行过,若不存在则标记为垃圾对象,等待回收;若有的话,则进行第二次标记;第二次标记将当前对象放入F-Queue队列,并生成一个finalize线程去执行该方法,虚拟机不保证该方法一定会被执行,这是因为如果线程执行缓慢或进入了死锁,会导致回收系统的崩溃;如果执行了finalize方法之后仍然没有与GC Roots有直接或者间接的引用,则该对象会被回收。

JVM有哪些垃圾收集器

年轻代的垃圾收集器

年轻代的垃圾收集器有Serial收集器、ParNew收集器、Parallel Scanvenge收集器,针对不同场景下,使用不同的垃圾收集器。

Serial收集器

- 是JVM最基本的、历史发展最悠久的收集器

- 单线程收集器,在进行GC时,必须暂停其他所有工作线程,直到GC结束

- 对于单CPU的服务器表现很优秀,无线程交互的开销,专心做垃圾回收

ParNew收集器

- Serial收集器的多线程版本

- 响应速度优先,适用于一些应用项目,追求用户体验

- 默认开启的回收线程数量和CPU数量相同

Parallel Scanvenge收集器

- 多线程垃圾回收

- 吞吐量优先,适用于一些计算型项目,用户交互少,吞吐量=运行用户代码时间/(运行用户代码时间+GC时间)

老年代的垃圾收集器

老年代的垃圾收集器有Serial Old收集器、Parallel Old收集器、CMS收集器。

Serial Old收集器

- Serial收集器老年代版本

- 使用标记整理算法

- 单线程收集器,在进行GC时,必须暂停其他所有工作线程,直到GC结束

- 对于单CPU的服务器表现很优秀,无线程交互的开销,专心做垃圾回收

Parallel Old收集器

- Parallel Scanvenge老年代版本

- 使用标记整理算法

- 多线程回收机制,适合计算类型项目,强调吞吐量

CMS收集器

- 以获取最短回收停顿时间为目标

- 并发收集,低停顿,但是在并发的过程中可能会形成新的垃圾,也就是浮动垃圾

- 使用的是标记清理算法,会产生内存碎片

- 对CPU资源敏感,默认启动的回收线程是(CPU+3)/4,但在CPU数量4以上时,回收线程数量不小于CPU数量的25%

G1、ZGC回收器

G1(Garbage First)收集器 (标记-整理算法)

Java堆并行收集器,G1收集器是JDK1.7提供的一个新收集器,G1收集器基于“标记-整理”算法实现,也就是说不会产生内存碎片。此外,G1收集器不同于之前的收集器的一个重要特点是:G1回收的范围是整个Java堆(包括新生代,老年代),而前六种收集器回收的范围仅限于新生代或老年代。

ZGC (Z Garbage Collector)收集器

是一款由Oracle公司研发的,以低延迟为首要目标的一款垃圾收集器。它是基于动态Region内存布局,(暂时)不设年龄分代,使用了读屏障、染色指针和内存多重映射等技术来实现可并发的标记-整理算法的收集器。在 JDK 11 新加入,还在实验阶段,主要特点是:回收TB级内存(最大4T),停顿时间不超过10ms。

优点: 低停顿,高吞吐量, ZGC 收集过程中额外耗费的内存小。

缺点: 浮动垃圾。

垃圾回收器间的配合使用图

各个垃圾回收器对比

CMS收集器执行过程

CMS(Concurrent Mark Sweep,并发标记清除) 收集器是以获取最短回收停顿时间为目标的收集器(追求低停顿),它在垃圾收集时使得用户线程和 GC 线程并发执行,因此在垃圾收集过程中用户也不会感到明显的卡顿。

从名字就可以知道,CMS是基于“标记-清除”算法实现的。CMS 回收过程分为以下四步:

初始标记 (CMS initial mark):主要是标记 GC Root 开始的下级(注:仅下一级)对象,这个过程会 STW,但是跟 GC Root 直接关联的下级对象不会很多,因此这个过程其实很快。

并发标记 (CMS concurrent mark):根据上一步的结果,继续向下标识所有关联的对象,直到这条链上的最尽头。这个过程是多线程的,虽然耗时理论上会比较长,但是其它工作线程并不会阻塞,没有 STW。

重新标记(CMS remark):顾名思义,就是要再标记一次。为啥还要再标记一次?因为第 2 步并没有阻塞其它工作线程,其它线程在标识过程中,很有可能会产生新的垃圾。

并发清除(CMS concurrent sweep):清除阶段是清理删除掉标记阶段判断的已经死亡的对象,由于不需要移动存活对象,所以这个阶段也是可以与用户线程同时并发进行的。

CMS 的问题

- 并发回收导致CPU资源紧张

在并发阶段,它虽然不会导致用户线程停顿,但却会因为占用了一部分线程而导致应用程序变慢,降低程序总吞吐量。CMS默认启动的回收线程数是:(CPU核数 + 3)/ 4,当CPU核数不足四个时,CMS对用户程序的影响就可能变得很大。

- 无法清理浮动垃圾

在CMS的并发标记和并发清理阶段,用户线程还在继续运行,就还会伴随有新的垃圾对象不断产生,但这一部分垃圾对象是出现在标记过程结束以后,CMS无法在当次收集中处理掉它们,只好留到下一次垃圾收集时再清理掉。这一部分垃圾称为“浮动垃圾”。

- 并发失败(Concurrent Mode Failure)

由于在垃圾回收阶段用户线程还在并发运行,那就还需要预留足够的内存空间提供给用户线程使用,因此CMS不能像其他回收器那样等到老年代几乎完全被填满了再进行回收,必须预留一部分空间供并发回收时的程序运行使用。默认情况下,当老年代使用了 92% 的空间后就会触发 CMS 垃圾回收,这个值可以通过 -XX: CMSInitiatingOccupancyFraction 参数来设置。

这里会有一个风险:要是CMS运行期间预留的内存无法满足程序分配新对象的需要,就会出现一次“并发失败”(Concurrent Mode Failure),这时候虚拟机将不得不启动后备预案:Stop The World,临时启用 Serial Old 来重新进行老年代的垃圾回收,这样一来停顿时间就很长了。

- 内存碎片问题

CMS是一款基于“标记-清除”算法实现的回收器,这意味着回收结束时会有内存碎片产生。内存碎片过多时,将会给大对象分配带来麻烦,往往会出现老年代还有很多剩余空间,但就是无法找到足够大的连续空间来分配当前对象,而不得不提前触发一次 Full GC 的情况。

为了解决这个问题,CMS收集器提供了一个 -XX:+UseCMSCompactAtFullCollection 开关参数(默认开启),用于在 Full GC 时开启内存碎片的合并整理过程,由于这个内存整理必须移动存活对象,是无法并发的,这样停顿时间就会变长。还有另外一个参数 -XX:CMSFullGCsBeforeCompaction,这个参数的作用是要求CMS在执行过若干次不整理空间的 Full GC 之后,下一次进入 Full GC 前会先进行碎片整理(默认值为0,表示每次进入 Full GC 时都进行碎片整理)。

CMS收集器出现Concurrent Mode Failure的场景

CMS在进行并发清理的时候,是与用户线程同步进行,如果这个时候从年轻代晋升到老年代或者创建的大对象直接进入老年代,导致老年代的内存不足,抛出Concurrent Mode Failure异常,就会触发Serial Old,stop the world单线程进行垃圾收集,Serial Old采用的是标记整理的算法,在垃圾收集的同时,也会整理老年代的内存空间。从这些内容中总结触发Concurrent Mode Failure的可能如下:

- 在并发清理的时候,年轻代晋升到老年代或者大对象进入老年代的时候,内存担保机制失败,触发Concurrent Mode Failure;

- CMS在设置垃圾清理的上限值过高,导致CMS垃圾收集触发太晚,设置参数是

-XX:CMSInitiatingOccupancyFraction,在JDK5的时候默认值是68%,JDK7及以后默认值是92%,一般保持默认值即可; - 空间碎片太多,因为CMS采用的是标记清理算法,不会对内存进行整理,导致在年轻代晋升到老年代或者大对象进入老年代的时候无足够的连续内存空间,内存担保机制失败,触发Concurrent Mode Failure;